PHẦN 1 — GIỚI THIỆU & KHÁI NIỆM CỐT LÕI VỀ DATA WAREHOUSE

1. Giới thiệu

Mình muốn bắt đầu chương này bằng một câu hỏi rất thực tế: “Tại sao doanh nghiệp cần một nơi lưu trữ dữ liệu riêng cho phân tích, thay vì dùng luôn cơ sở dữ liệu đang vận hành hằng ngày?”. Nếu bạn thử chạy một truy vấn phân tích lớn trên hệ thống bán hàng đang hoạt động, bạn sẽ thấy nó chậm đi đáng kể và có thể làm gián đoạn giao dịch của khách hàng. Điều này cho thấy nhu cầu tách biệt giữa OLTP – xử lý giao dịch hằng ngày và OLAP – phân tích đa chiều phục vụ quyết định. Dữ liệu phục vụ phân tích cần lịch sử dài, tính nhất quán và khả năng tổng hợp mà database vận hành không cung cấp được. Chính vì vậy, data warehouse ra đời như một nền tảng tách biệt, nơi dữ liệu được chuẩn hóa, tích hợp và lưu trữ dài hạn để trả lời những câu hỏi chiến lược.

NOTE:

OLAP: Online Analytical Processing - hệ thống phân tích, tổng hợp các data OLTP: Online Transaction Processing - hệ thống tối ưu cho việc ghi – sửa – đọc các giao dịch nhỏ, nhiều, xảy ra liên tục.

Khi nhìn vào bản chất của một data warehouse, mình thấy nó giống như một bộ nhớ dài hạn của doanh nghiệp. Nếu hệ thống giao dịch là trí nhớ ngắn hạn, chỉ giữ thông tin mới nhất, thì warehouse là nơi lưu lại diễn biến nhiều năm. Quyết định quản trị cần góc nhìn rộng và sâu, do đó không thể thiếu lịch sử. Nhưng để xây dựng được một kho dữ liệu như vậy, ta cần hiểu rõ các đặc tính của nó: hướng chủ đề, tích hợp, gắn với thời gian và không biến động theo giao dịch tức thời. Đây chính là nền móng của toàn bộ chương.

2. Bốn đặc tính nền tảng của Data Warehouse

Khi W. H. Inmon định nghĩa “data warehouse”, ông nhấn mạnh bốn đặc tính: subject-oriented, integrated, time-variant, non-volatile. Mình muốn diễn giải từng đặc tính bằng cách liên hệ với đời sống của một doanh nghiệp.

2.1 Subject-oriented: Tổ chức xoay quanh chủ đề phân tích

Trong hệ thống vận hành, dữ liệu được tổ chức để hỗ trợ tác vụ nghiệp vụ như đặt hàng, thanh toán, hay kiểm kho. Nhưng trong data warehouse, mình không còn quan tâm đến hoạt động từng giao dịch mà tập trung vào các chủ đề như khách hàng, sản phẩm, hoặc doanh thu. Điều này giúp dữ liệu được sắp xếp theo những gì nhà quản trị cần phân tích thay vì theo logic của ứng dụng. Ví dụ, khi phân tích hành vi khách hàng, mình chỉ cần một tập dữ liệu bao gồm thông tin khách hàng từ nhiều nguồn mà không bị chi phối bởi cấu trúc phức tạp của hệ thống vận hành.

2.2 Integrated: Tích hợp từ nhiều nguồn khác nhau

Một doanh nghiệp có thể lưu dữ liệu ở nhiều hệ thống như CRM, ERP, file log, hay giao dịch trực tuyến. Mỗi nơi có định dạng khác nhau, quy tắc mã hóa khác nhau, thậm chí đơn vị đo cũng khác nhau. Data warehouse đóng vai trò hòa trộn các nguồn này vào một chuẩn chung để đảm bảo tính nhất quán toàn hệ thống. Khi khách sạn A báo giá theo USD nhưng khách sạn B theo EUR, warehouse phải chuyển đổi để dữ liệu trở nên đồng nhất. Chính bước tích hợp này giúp các phân tích sau đó không bị sai lệch.

2.3 Time-variant: Thời gian là yếu tố bắt buộc

Mình nhận thấy điểm khác biệt rõ nhất giữa warehouse và database vận hành là cách xử lý thời gian. Database vận hành chỉ giữ giá trị “hiện tại”, trong khi warehouse lưu lại nhiều năm dữ liệu, thường từ 5–10 năm. Mỗi bảng trong warehouse đều có dấu vết thời gian, từ khóa chính, foreign key đến từng bản ghi, nhằm phục vụ phân tích xu hướng và dự báo. Nếu không lưu lịch sử dài hạn, doanh nghiệp không thể phân tích sự thay đổi hành vi khách hàng, độ ổn địnÏh của nhà cung cấp hay chu kỳ mua hàng theo mùa.

2.4 Non-volatile: Không cập nhật như database vận hành

Trong warehouse, dữ liệu gần như không bị thay đổi, không có giao dịch ghi/xóa như hệ thống OLTP. Mình chỉ có hai hoạt động: nạp dữ liệu (load) và truy vấn dữ liệu (access). Không có rollback, transaction hay khóa dữ liệu, nên warehouse được tối ưu cho đọc và phân tích. Điều này cho phép xây dựng các cấu trúc dữ liệu đặc biệt như data cube để tăng tốc truy vấn.

3. OLTP và OLAP: Tại sao phải tách biệt?

Để giúp bạn hình dung rõ ràng hơn, hãy thử tưởng tượng bạn đang trực tiếp giao dịch trên một website thương mại điện tử. Trong lúc bạn thanh toán, một truy vấn phân tích phức tạp lại được chạy trên cùng hệ thống để thống kê doanh thu theo năm. Điều này có thể làm hệ thống bị chậm, thậm chí làm rớt giao dịch. Bảng so sánh giữa OLTP và OLAP ở đây cho thấy hai hệ thống khác nhau từ mục tiêu, thiết kế dữ liệu, loại truy vấn đến dung lượng và số người dùng.

| Tính năng | OLTP | OLAP |

|---|---|---|

| Đặc trưng (Characteristic) | xử lý tác vụ vận hành | xử lý thông tin |

| Định hướng (Orientation) | giao dịch | phân tích |

| Người dùng (User) | nhân viên nghiệp vụ, DBA, chuyên gia cơ sở dữ liệu | người dùng tri thức (ví dụ: quản lý, giám đốc, nhà phân tích) |

| Chức năng (Function) | vận hành hàng ngày | yêu cầu thông tin dài hạn, hỗ trợ ra quyết định |

| Thiết kế CSDL (DB design) | dựa trên mô hình ER, hướng ứng dụng | mô hình star/snowflake, hướng chủ đề |

| Dữ liệu (Data) | dữ liệu hiện tại, đảm bảo cập nhật | dữ liệu lịch sử, duy trì độ chính xác theo thời gian |

| Tóm lược dữ liệu (Summarization) | thô, rất chi tiết | đã tóm lược, được hợp nhất |

| Dạng nhìn dữ liệu (View) | chi tiết, dạng quan hệ phẳng | tóm tắt dạng đa chiều |

| Đơn vị công việc (Unit of work) | giao dịch ngắn, đơn giản | truy vấn phức tạp |

| Cách truy cập (Access) | đọc/ghi | chủ yếu đọc |

| Trọng tâm (Focus) | dữ liệu đi vào | thông tin đi ra |

| Hoạt động (Operations) | đánh index/hash trên khóa chính | nhiều phép quét (scan) |

| Số lượng bản ghi được truy cập (Number of records accessed) | vài chục | hàng triệu |

| Số lượng người dùng (Number of users) | hàng nghìn | hàng trăm |

| Kích thước CSDL (DB size) | từ GB đến nhiều GB | từ TB trở lên |

| Ưu tiên (Priority) | hiệu năng cao, luôn sẵn sàng | tính linh hoạt, tự chủ người dùng |

| Chỉ số đo lường (Metric) | thông lượng giao dịch | thông lượng truy vấn, thời gian phản hồi |

| Bảng dựa trên Chaudhuri and Dayal. |

Hệ thống OLTP được thiết kế để xử lý rất nhiều giao dịch nhỏ, ngắn và chính xác. Ngược lại, OLAP dùng để chạy các truy vấn đọc lớn, phức tạp và yêu cầu dữ liệu lịch sử. Vì hai mục tiêu này hoàn toàn khác nhau, việc chia tách OLTP và warehouse là điều cần thiết để đạt hiệu năng tối ưu cho cả hai. Khi warehouse xử lý dữ liệu tổng hợp, OLTP vẫn vận hành bình thường mà không bị ảnh hưởng.

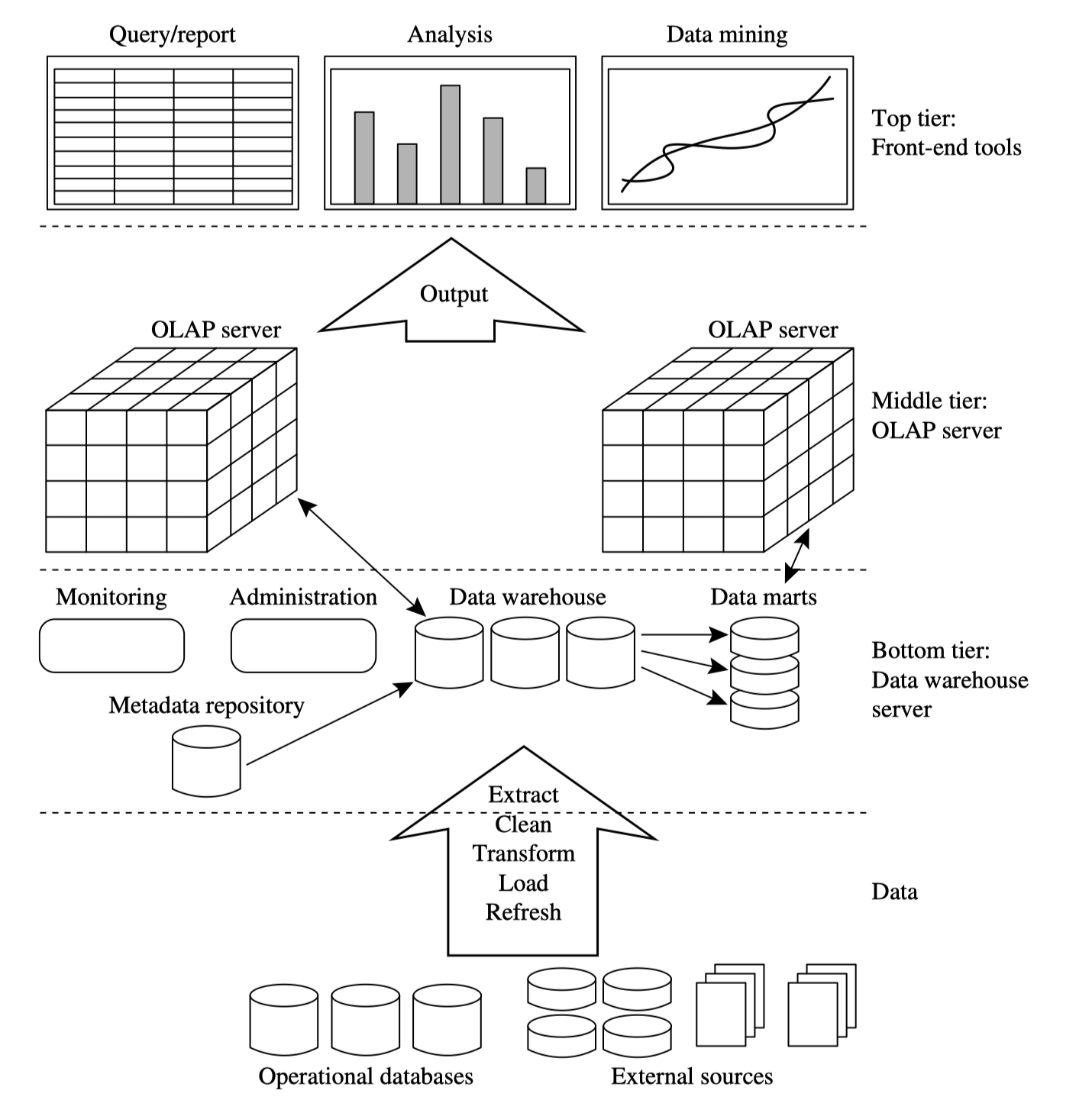

4. Kiến trúc nhiều tầng của Data Warehouse

Một data warehouse không phải chỉ là một database lớn, mà là một hệ thống gồm nhiều tầng. Trên cùng là các công cụ phân tích và báo cáo; bên dưới là lớp OLAP server; dưới nữa là kho lưu trữ dữ liệu; và bên dưới cùng là các hệ thống nguồn.

Khi nguồn dữ liệu từ các hệ thống vận hành được đưa vào warehouse, nó đi qua quá trình ETL bao gồm trích xuất, làm sạch, chuyển đổi và nạp. Sau khi dữ liệu nằm trong warehouse, OLAP engine chịu trách nhiệm tạo ra các cấu trúc phân tích như cube và cung cấp giao diện cho các công cụ phân tích. Ở lớp trên cùng, người dùng có thể chạy truy vấn, tạo báo cáo, hoặc thực hiện khai phá dữ liệu. Tất cả đều dựa trên một tầng metadata mô tả cấu trúc, lineage và quy tắc chuyển đổi của dữ liệu.

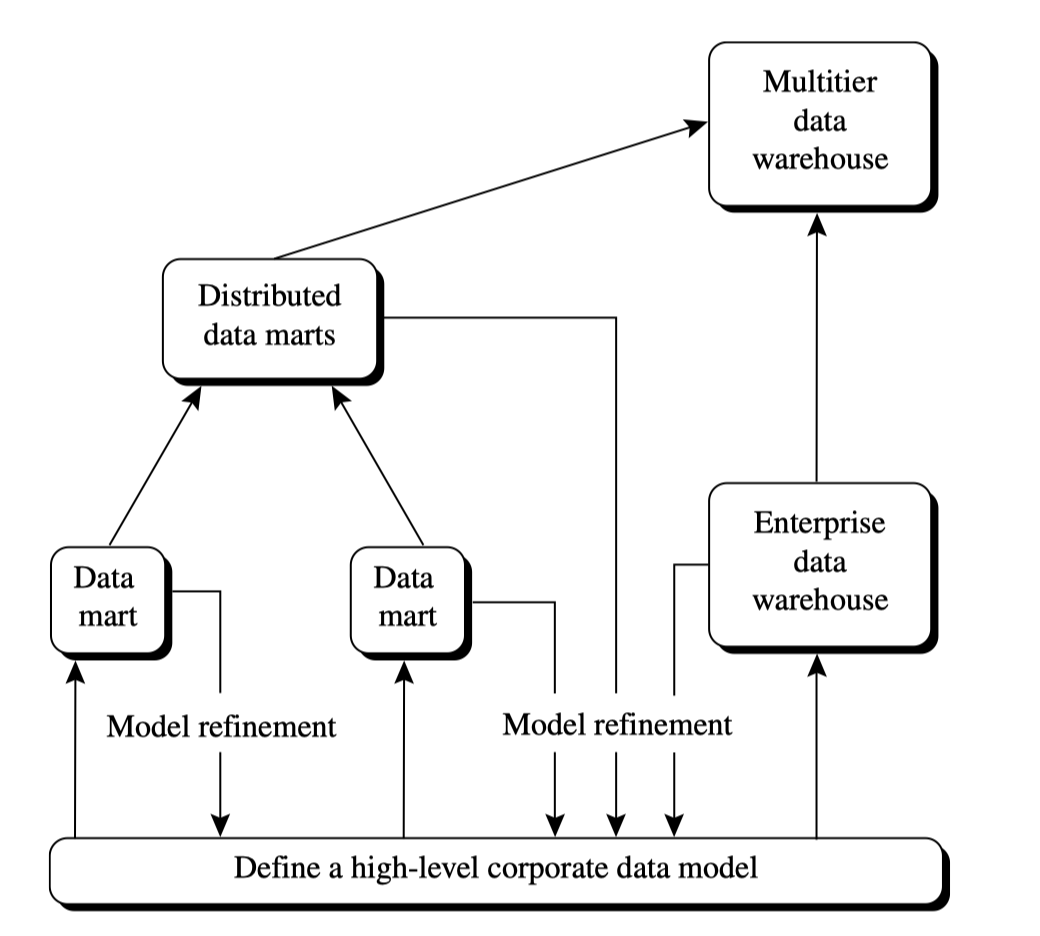

5. Các mô hình data warehouse: Enterprise, Data Mart và Virtual Warehouse

Mình thường ví ba mô hình này như ba cấp độ của một thành phố dữ liệu. Enterprise warehouse là toàn thành phố, data mart là từng quận chuyên biệt, còn virtual warehouse giống một “bản đồ ảo” của thành phố.

Enterprise warehouse là nơi thu thập toàn bộ dữ liệu của doanh nghiệp và phục vụ rất nhiều nhóm người dùng. Data mart thu hẹp phạm vi, chỉ phục vụ một nhóm như marketing hoặc tài chính. Virtual warehouse lại nhẹ hơn, chỉ là tập hợp các view trên database vận hành, giúp tiết kiệm tài nguyên khi chưa cần warehouse đầy đủ.

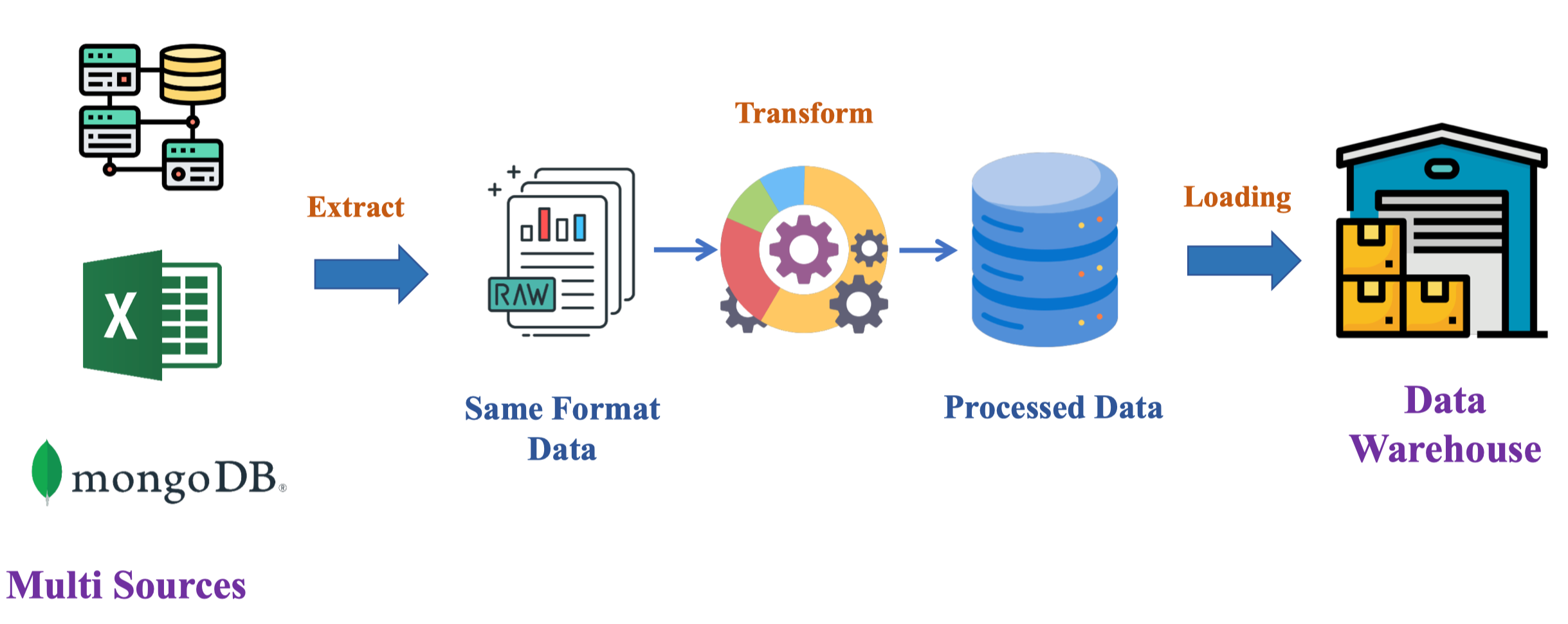

6. ETL – Hệ tuần hoàn của warehouse

Đọc thêm về các kĩ thuật ETL: M03W1.5__ETL pipeline

Để warehouse hoạt động đúng, ta cần hệ thống ETL. Mình thấy ETL như một “dây chuyền lọc” để biến dữ liệu hỗn tạp thành dạng chuẩn hóa và an toàn.

Quá trình ETL gồm năm bước. Đầu tiên, dữ liệu được trích xuất từ nhiều nguồn như file, database hoặc hệ thống ngoại lai. Sau đó, bước làm sạch bên trong ETL giúp phát hiện và sửa lỗi theo khả năng. Khi dữ liệu sạch, quá trình chuyển đổi sẽ chuẩn hóa schema và cấu trúc để phù hợp với warehouse. Tiếp theo, bước nạp dữ liệu vào warehouse đảm bảo sorting, summarizing và kiểm tra integrity. Cuối cùng, việc refresh giúp warehouse cập nhật theo chu kỳ.

PHẦN 2 — DATA CUBE & OLAP: TƯ DUY ĐA CHIỀU TRONG PHÂN TÍCH

7. Hiểu trực giác về phân tích đa chiều và Data Cube

“Nếu chúng ta muốn xem doanh thu theo vùng, theo sản phẩm và theo thời gian cùng lúc, ta nên tổ chức dữ liệu thế nào để truy vấn nhanh nhất?”. Nếu dữ liệu chỉ ở dạng hai chiều như bảng quan hệ truyền thống, việc tổng hợp theo nhiều chiều cùng lúc sẽ trở nên phức tạp và chậm. Bởi vì bảng quan hệ xử lý rất tốt cho truy vấn chi tiết, nhưng khi phải xoay chiều dữ liệu để nhìn ở góc độ mới, nó bắt đầu bộc lộ giới hạn. Chính nhu cầu phân tích nhiều góc nhìn cùng lúc đã dẫn đến ý tưởng về data cube, nơi mỗi chiều của cube tượng trưng cho một chiều phân tích như thời gian, sản phẩm hoặc khu vực.

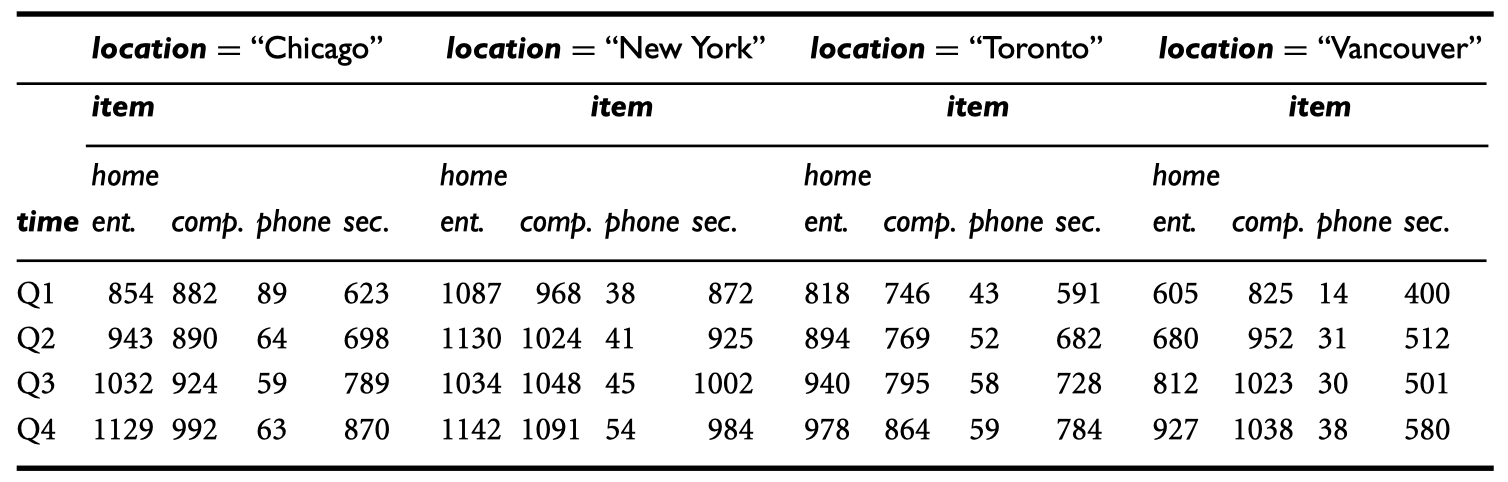

Ví dụ bảng dữ liệu bán hàng 3-D:

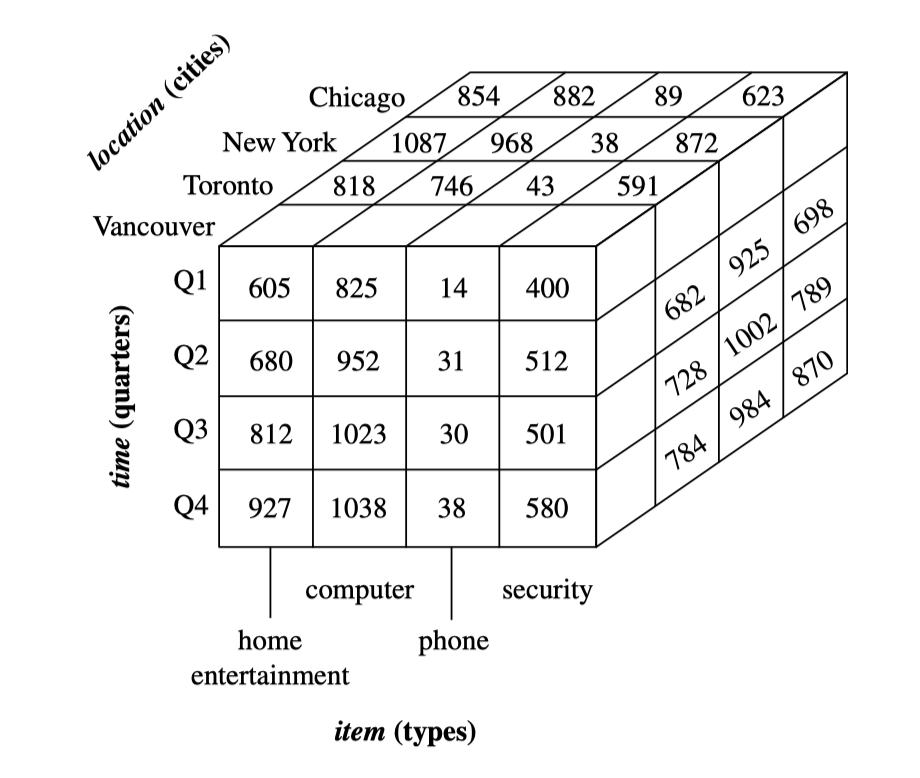

Khi hình dung data cube, mình thấy nó giống chiếc “khối rubik” dữ liệu. Mỗi mặt thể hiện một góc nhìn, mỗi lớp lát cắt cho một điều kiện lọc, và mỗi ô trong cube là một giá trị đo lường như tổng doanh thu. Dữ liệu từ bảng fact và dimension được kết hợp thành không gian đa chiều, giúp việc “xoay” dữ liệu rất tự nhiên. Chính vì vậy, data cube trở thành phương thức trực quan để tổng hợp dữ liệu và trả lời các câu hỏi phân tích phức tạp mà không tốn quá nhiều thời gian tính toán lại mỗi lần.

Mình thấy rằng mỗi trục của cube tương ứng với một dimension: trục đứng là thời gian (Q1–Q4), trục ngang là item (home entertainment, computer, phone, security), và trục sâu là location (Chicago, New York, Toronto, Vancouver). Mỗi ô nhỏ trong khối là giá trị dollars_sold được lấy trực tiếp từ Bảng dữ liệu

8. OLAP Operations: Roll-up, Drill-down, Slice, Dice và Pivot

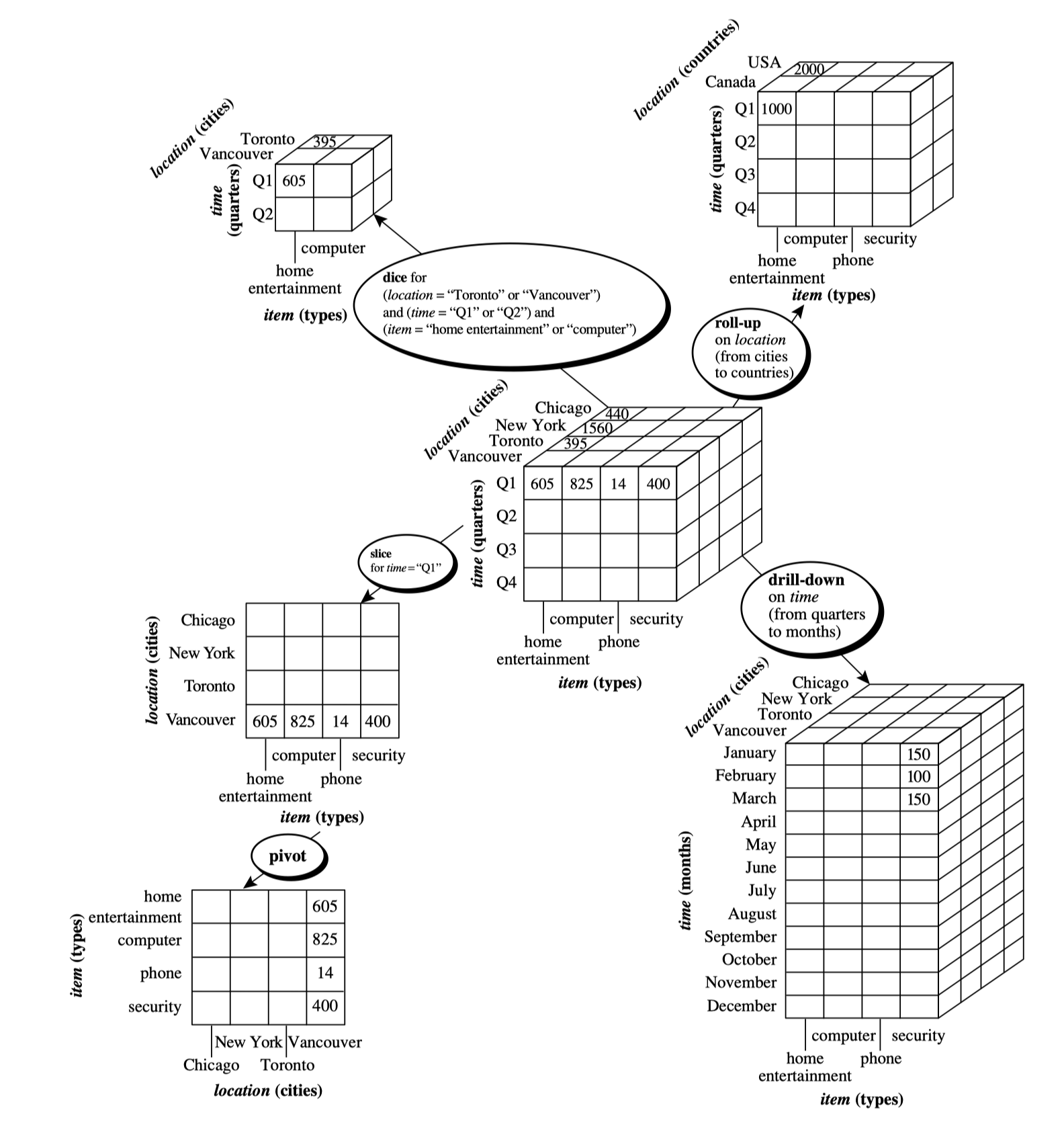

Khi đã có data cube, người phân tích có thể thực hiện nhiều thao tác để khám phá dữ liệu. Mình xem các thao tác này như các chuyển động trên khối rubik: thu nhỏ, phóng lớn, cắt lát hoặc xoay hướng để tạo góc nhìn mới.

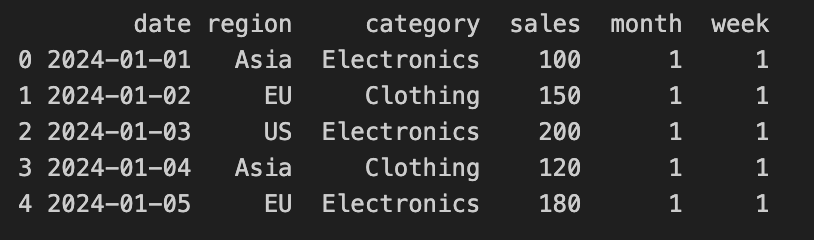

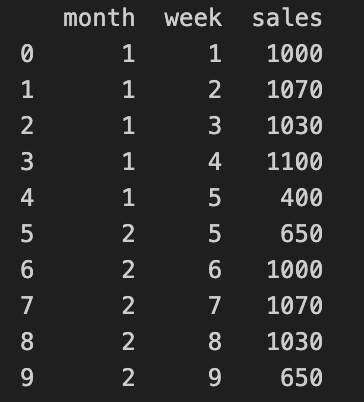

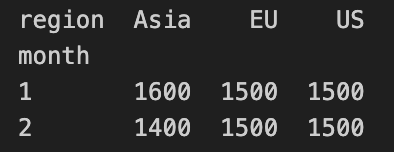

Ví dụ ta có dataset sau:

import pandas as pd

df = pd.DataFrame({

"date": pd.date_range("2024-01-01", periods=60, freq="D"),

"region": ["Asia", "EU", "US"] * 20,

"category": ["Electronics", "Clothing"] * 30,

"sales": [100, 150, 200, 120, 180] * 12

})

df["month"] = df["date"].dt.month

df["week"] = df["date"].dt.isocalendar().week

df.head()

Roll-up là hành động tổng hợp dữ liệu lên mức trừu tượng cao hơn. Ví dụ thay vì xem doanh thu theo từng ngày, mình “roll-up” lên tháng hoặc quý. Quá trình này giống như gộp các lớp nhỏ thành một lớp lớn hơn.

# Roll-up: tổng hợp doanh thu theo tháng

rollup_month = df.groupby("month")["sales"].sum().reset_index()

print(rollup_month) month sales

0 1 4600

1 2 4400

Ngược lại, drill-down giúp phân rã dữ liệu xuống mức chi tiết hơn, như từ doanh thu theo tháng xuống từng tuần. Cả hai thao tác này dựa vào hierarchy được định nghĩa trong từng dimension.

# Drill-down: phân rã doanh thu theo tuần trong từng tháng

drilldown_week = df.groupby(["month", "week"])["sales"].sum().reset_index()

print(drilldown_week)

Slice và dice là hai thao tác mình dùng để chọn một phần của cube. Slice là lựa chọn một lát theo một giá trị cụ thể, ví dụ chọn “khu vực = Châu Á”. Dice thì kết hợp nhiều điều kiện, như vừa chọn “Châu Á” vừa chọn “Danh mục sản phẩm = Điện tử”. Cuối cùng, pivot cho phép xoay chiều dữ liệu, biến hàng thành cột để tạo một bảng trực quan hơn cho phân tích. Tất cả những thao tác này giúp người dùng khám phá dữ liệu theo nhiều hướng mà không cần viết truy vấn SQL phức tạp.

# Slice: chọn region = "Asia"

slice_asia = df[df["region"] == "Asia"]

print(slice_asia.head())

# Dice: region = "Asia" & category = "Electronics"

dice_mult = df[(df["region"] == "Asia") & (df["category"] == "Electronics")]

print(dice_mult.head())

# Pivot: hàng = tháng, cột = region, giá trị = tổng sales

pivot_table = df.pivot_table(

index="month",

columns="region",

values="sales",

aggfunc="sum"

)

print(pivot_table)

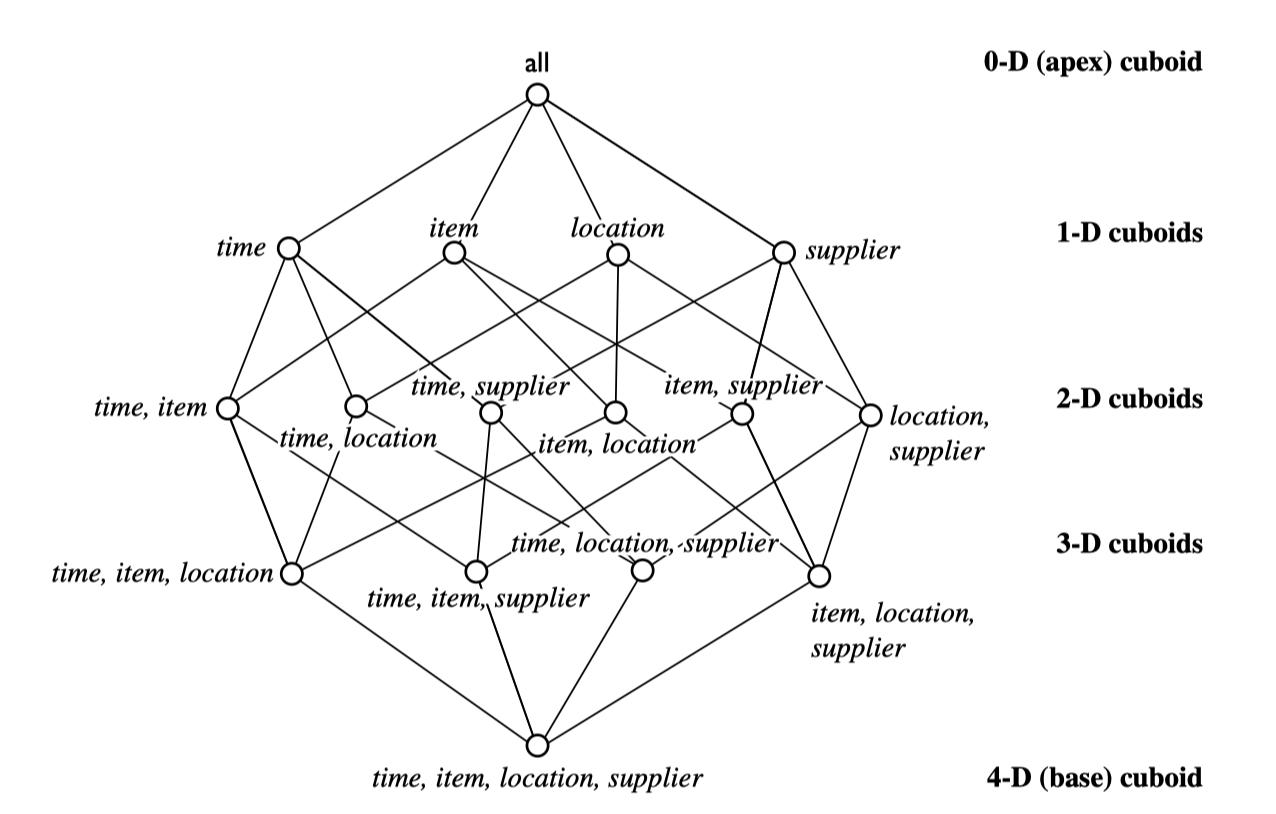

9. Tập hợp đa chiều và khái niệm lattice of cuboids

Một cube đầy đủ thực chất không chỉ có một phiên bản duy nhất. Khi xây dựng cube với n chiều, ta có tổng cộng cách kết hợp các chiều, tạo thành các cuboid từ mức chi tiết nhất đến tổng hợp nhất. Ví dụ với ba chiều như thời gian, sản phẩm và địa lý, ta sẽ có các cuboid như , , , , và cuối cùng là cuboid tổng hợp – đại diện cho một giá trị duy nhất như tổng doanh thu.

Tập hợp các cuboid là một “lattice”, nơi mỗi node đại diện cho một mức tổng hợp và các cạnh thể hiện mối quan hệ giữa các mức đó. Lattice giúp engine OLAP biết khi nào có thể tái sử dụng các tổng hợp đã tính trước, thay vì phải tính lại từ dữ liệu gốc. Nhờ vậy, việc truy vấn trở nên nhanh hơn rất nhiều, đặc biệt trong warehouse có hàng chục triệu bản ghi. Việc chọn cuboid nào để materialize luôn là quyết định quan trọng nhằm cân bằng giữa tốc độ truy vấn và chi phí lưu trữ.

Giả sử có 3 dimension:

-

Time: Day → Month → Quarter → Year

-

Location: City → State → Country

-

Product: SKU → Category

Hãy tự hỏi:

Ta có thể tổng hợp dữ liệu theo bao nhiêu cách khác nhau?

Ví dụ:

-

Day × City × SKU

-

Month × City × Category

-

Quarter × State × Category

-

Year × Country

-

Month × Country × SKU

-

…

Tất cả những tổ hợp này tạo thành một lattice.

NOTE: Materialize: Tính toán trước kết quả của một truy vấn và lưu nó thành bảng vật lý (physical table), thay vì chỉ giữ nó như một truy vấn logic.

10. Hiện thực Data Cube: Full, No và Partial Materialization

Khi triển khai cube trong thực tế, ta có ba lựa chọn cho việc lưu trữ: full materialization, no materialization hoặc partial materialization. Full materialization nghĩa là ta lưu toàn bộ các cuboid trong lattice. Điều này giúp truy vấn cực kỳ nhanh, nhưng chi phí lưu trữ rất lớn, đặc biệt khi số chiều tăng cao. Ngược lại, no materialization không lưu sẵn gì cả và chỉ tính toán khi truy vấn được gọi, dẫn đến thời gian xử lý lâu nhưng tiết kiệm dung lượng.

Trong phần lớn các hệ thống OLAP thực tế, partial materialization là cách tiếp cận hợp lý nhất. Ta chọn trước một tập cuboid quan trọng, thường dựa trên tần suất truy vấn và nhu cầu phân tích, để lưu sẵn. Những cuboid ít được dùng thì tính động khi cần. Điều này tạo ra sự cân bằng giữa tốc độ và chi phí. Việc chọn cuboid nào để materialize cũng liên quan đến thuật toán tối ưu, dựa trên kích thước cuboid, yêu cầu từ người dùng và profile truy vấn.

11. Phân vùng và nén trong OLAP: Tối ưu cho truy vấn lớn

Một cube lớn có thể chứa dữ liệu từ nhiều năm và hàng chục chiều phân tích. Nếu lưu toàn bộ dưới dạng bảng phẳng, hệ thống sẽ mất nhiều thời gian để đọc và tổng hợp. Vì vậy, warehouse sử dụng các kỹ thuật như phân vùng (partitioning) và nén (compression). Phân vùng theo thời gian là kỹ thuật phổ biến nhất, vì phần lớn truy vấn phân tích đều theo từng tháng, quý hoặc năm. Việc phân vùng giúp engine chỉ đọc phần dữ liệu cần thiết thay vì toàn bộ bảng.

Nén dữ liệu cũng quan trọng không kém. Trong OLAP, các giá trị fact thường lặp lại theo pattern rõ ràng, làm cho các thuật toán nén hoạt động hiệu quả. Khi dữ liệu được nén tốt, không chỉ giảm chi phí lưu trữ mà việc đọc dữ liệu từ disk cũng nhanh hơn. Với cơ chế nén theo cột, OLAP engine có thể xử lý các phép tổng hợp rất nhanh vì nó đọc trực tiếp vào vùng dữ liệu của cột đó mà không phải nạp toàn bộ record.

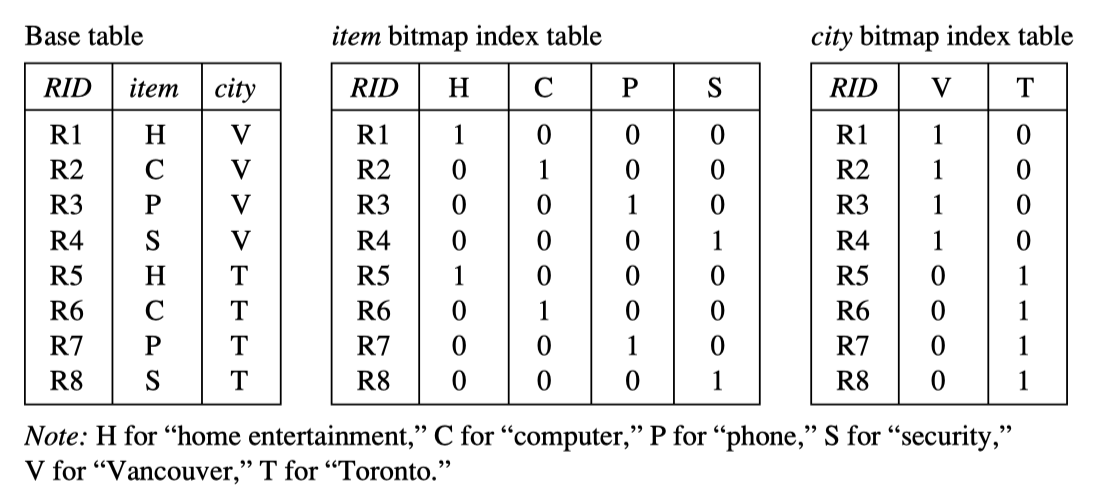

12. Aggregation và Indexing trong OLAP

Aggregation là linh hồn của OLAP vì phần lớn truy vấn đều yêu cầu tổng hợp dữ liệu theo từng mức độ. Mình nhận thấy việc tối ưu aggregation là yếu tố giúp OLAP khác biệt hoàn toàn so với OLTP. Trong slide, các kỹ thuật như index trees, bitmap indexing hay join indexing được sử dụng để tăng tốc quá trình tính toán. Index trong warehouse không chỉ dùng để tìm bản ghi nhanh hơn, mà còn để hỗ trợ việc tổng hợp theo nhiều chiều cùng lúc.

Bitmap indexing là ví dụ tiêu biểu, vì mỗi giá trị của dimension tương ứng một bitmap. Khi lọc dữ liệu, engine chỉ cần thực hiện phép AND hoặc OR giữa các bitmap, giúp truy vấn chạy rất nhanh. Join indexing cũng được dùng khi muốn nối bảng fact với bảng dimension theo cách tối ưu, tránh việc quét toàn bộ dữ liệu. Những cấu trúc chỉ mục này được thiết kế riêng cho OLAP và đem lại hiệu suất vượt trội trong phân tích nhiều chiều.

PHẦN 3 — KIẾN TRÚC OLAP & SO SÁNH MOLAP, ROLAP, HOLAP

14. Vì sao cần OLAP Server?

Khi dữ liệu đã nằm trong warehouse, câu hỏi tiếp theo là: “Làm sao để phân tích đa chiều nhanh nhất có thể?”. Nếu mình chạy truy vấn trực tiếp trên warehouse quan hệ, việc tổng hợp theo nhiều chiều sẽ rất chậm vì SQL không được thiết kế tối ưu cho phân tích đa mức. Do đó, hệ thống OLAP server ra đời như một lớp trung gian, nơi các phép toán roll-up, drill-down hay slice được tối ưu nhờ dữ liệu được tổ chức theo cấu trúc đa chiều. OLAP server tạo ra các cấu trúc dữ liệu đặc biệt như data cube để tăng tốc truy vấn một cách đáng kể.

Mình hay ví OLAP server như “bộ não phân tích” của warehouse. Trong khi warehouse là nơi lưu trữ lâu dài, OLAP server tập trung xây dựng không gian đa chiều từ dữ liệu đó. Khi người dùng gửi truy vấn, server biết phải lấy dữ liệu từ cuboid nào, tái sử dụng các tổng hợp đã tính sẵn ra sao và áp dụng chỉ mục nào để trả lời nhanh nhất.

15. Ba kiến trúc OLAP: MOLAP, ROLAP và HOLAP

Ở phần này, mình muốn giải thích ba mô hình của OLAP theo trực giác trước. Bạn có thể tưởng tượng MOLAP giống như một “căn phòng đã sắp xếp mọi thứ thành từng ô”, ROLAP giống như “kho hàng dạng bảng” và HOLAP là sự kết hợp của cả hai. Mỗi mô hình có điểm mạnh riêng tùy theo kích thước dữ liệu và dạng truy vấn.

15.1. MOLAP – Multidimensional OLAP

MOLAP lưu dữ liệu theo dạng đa chiều gốc, nghĩa là cube được materialize trực tiếp trong hệ thống lưu trữ riêng. Vì dữ liệu nằm trong cấu trúc đa chiều, truy vấn như roll-up hay slice rất nhanh. MOLAP được cho là mô hình có hiệu năng tốt nhất cho đa chiều nhưng bị hạn chế khi dữ liệu quá lớn.

Trong MOLAP, toàn bộ cube hoặc phần lớn cuboid được lưu dưới dạng nén, và engine có thể tính toán tổng hợp trong bộ nhớ rất nhanh. Tuy nhiên, khi số bản ghi vượt quá ngưỡng, chi phí lưu trữ tăng mạnh. Vì vậy MOLAP thường dùng cho dữ liệu vừa và nhỏ, hoặc khi yêu cầu phân tích rất nặng về đa chiều.

15.2. ROLAP – Relational OLAP

ROLAP là cách tiếp cận khác hẳn. Thay vì lưu cube trực tiếp, ROLAP sử dụng hệ quản trị quan hệ (RDBMS) để biểu diễn dữ liệu đa chiều thông qua bảng fact và dimension. Điều này cho phép xử lý dữ liệu rất lớn vì tận dụng hạ tầng của RDBMS. Tuy nhiên, việc thực hiện roll-up hoặc drill-down cần join và group-by nhiều bảng, nên tốc độ xử lý thấp hơn MOLAP.

Mình thường thấy ROLAP phù hợp cho warehouse khổng lồ, nơi dung lượng vượt xa khả năng lưu cube của MOLAP. Dù truy vấn chậm hơn, nhưng các cải tiến như bitmap indexing hay star schema optimization giúp ROLAP vẫn hoạt động tốt trong thực tế.

15.3. HOLAP – Hybrid OLAP

HOLAP kết hợp hai mô hình trên: lưu tổng hợp ở dạng cube như MOLAP, còn dữ liệu chi tiết nằm trong RDBMS như ROLAP. Cách làm này giúp mình vừa có tốc độ khi cần truy vấn tổng hợp, vừa có khả năng mở rộng khi phân tích chi tiết.

Với HOLAP, engine quyết định phần nào của lattice cần lưu dưới dạng cube và phần nào truy vấn từ bảng quan hệ. Nhờ đó, hệ thống đạt cân bằng giữa hiệu năng – chi phí – dung lượng lưu trữ. Các warehouse lớn thường dùng HOLAP vì nó tránh được điểm yếu của từng mô hình riêng lẻ.

16. Ứng dụng: Khi nào nên dùng MOLAP, ROLAP và HOLAP?

Mình muốn trả lời câu hỏi quan trọng nhất: trong thực tế, khi nào nên chọn mô hình nào? Trực giác của mình là bạn cần xem xét ba yếu tố: dung lượng dữ liệu, khối lượng truy vấn phân tích và chi phí lưu trữ.

Với warehouse nhỏ đến trung bình, nơi phần lớn truy vấn là phân tích đa chiều phức tạp, MOLAP mang lại tốc độ tốt nhất. Ngược lại, warehouse từ vài terabyte đến nhiều petabyte cần tối ưu dung lượng nên ROLAP là lựa chọn hợp lý hơn. Nếu doanh nghiệp vừa cần truy vấn tổng hợp nhanh, vừa cần khai thác chi tiết sâu trên dữ liệu lớn, HOLAP là giải pháp tối ưu. Từ góc nhìn triển khai, HOLAP cũng linh hoạt hơn khi dữ liệu tăng trưởng theo thời gian.

17. Triển khai OLAP server trong thực tế

Khi triển khai OLAP, mình luôn để ý đến cấu trúc vật lý mà server lựa chọn để lưu cube. Một OLAP engine hiệu quả sẽ tự động chọn cuboid cần materialize dựa trên pattern truy vấn. Engine có thể sử dụng các chỉ mục như star indexes, bitmap indexes hoặc join indexes để tối ưu truy vấn.

Điểm mình thấy quan trọng là OLAP server luôn phải cân bằng giữa hiệu năng và tài nguyên. Chọn quá nhiều cuboid để materialize sẽ làm tăng chi phí và thời gian nạp dữ liệu. Chọn quá ít sẽ khiến truy vấn chậm. Do đó, hầu hết OLAP engine có một module gọi là “query optimizer” để học từ lịch sử truy vấn và điều chỉnh chiến lược materialization theo thời gian.

18. Thử xây dựng mini-OLAP bằng Python (ROLAP mô phỏng)

Để làm rõ sự khác biệt giữa MOLAP và ROLAP, mình sẽ mô phỏng ROLAP bằng cách tạo star schema đơn giản và thực hiện roll-up. Mục tiêu là minh họa cách fact table và dimension table tương tác trong OLAP.

Import pandas as pd

# Dimension tables

Product_dim = pd.DataFrame ({

"product_id": [1, 2],

"product_name": ["A", "B"]

})

Time_dim = pd.DataFrame ({

"time_id": [1, 2],

"month": ["2024-01", "2024-02"]

})

# Fact table

Fact = pd.DataFrame ({

"product_id": [1, 2, 1, 2],

"time_id": [1, 1, 2, 2],

"sales": [100, 150, 120, 160]

})

# Join to form star schema

Merged = fact.Merge (product_dim). Merge (time_dim)

# Roll-up: total sales by product

Rollup = merged.Groupby ("product_name")["sales"]. Sum ()Trong mô phỏng này, việc roll-up tương ứng với group-by trong SQL. Mình phải join fact với các bảng dimension, đây chính là bản chất của ROLAP: cấu trúc quan hệ và các phép kết hợp được dùng để thực hiện phân tích đa chiều. Tuy nhiên, khi dữ liệu lớn gấp hàng ngàn lần, MOLAP sẽ nhanh hơn vì đã có cuboid lưu sẵn.

**PHẦN 4 — MÔ HÌNH STAR, SNOWFLAKE & FACT CONSTELLATION

Kiến trúc quan hệ trong Data Warehouse

19. Vì sao cần mô hình hóa quan hệ trong Data Warehouse?

Trước khi đi vào OLAP đa chiều, mình muốn quay lại một câu hỏi nền tảng: “Làm sao tổ chức dữ liệu trong warehouse để vừa dễ phân tích, vừa dễ mở rộng?”. Trong các hệ thống OLTP, mô hình quan hệ được chuẩn hóa mạnh để tránh dư thừa và đảm bảo cập nhật nhanh. Nhưng trong warehouse, mục tiêu ngược lại: ưu tiên tốc độ đọc, tổng hợp và phân tích. Nếu giữ nguyên mô hình quan hệ chuẩn hóa, mỗi truy vấn OLAP sẽ phải join quá nhiều bảng, làm hệ thống rất chậm. Vì vậy, warehouse sử dụng những mô hình lược giản và tối ưu cho phân tích như star schema, snowflake schema và fact constellation.

Điều quan trọng là các mô hình này tách rõ ràng giữa fact table chứa các giá trị đo lường và dimension table chứa bối cảnh phân tích. Sự phân tách này giúp dữ liệu dễ hiểu, dễ xử lý và đặc biệt phù hợp với các thuật toán OLAP.

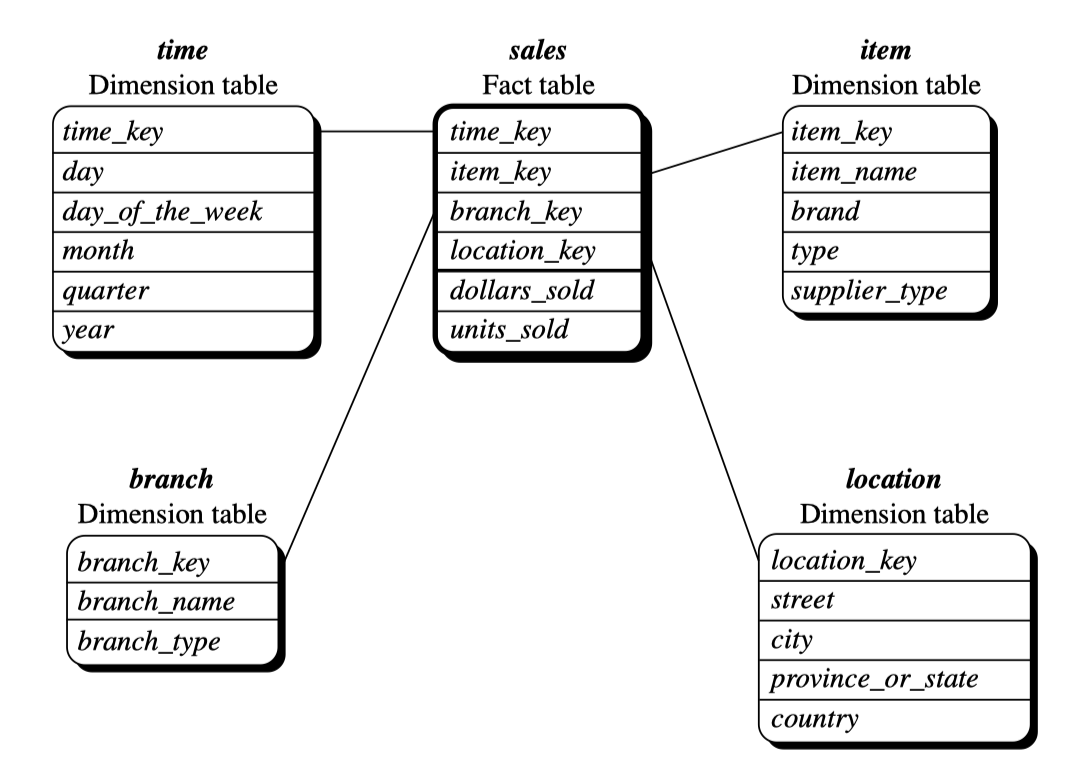

20. Star Schema – mô hình trực quan nhất của warehouse

Star schema là mô hình phổ biến nhất trong data warehouse vì sự đơn giản và hiệu quả của nó. Trong star schema, mọi dimension đều được gắn trực tiếp vào fact table bằng khóa ngoại. Khi mình nhìn vào mô hình này, nó giống như một ngôi sao năm cánh: fact table nằm ở trung tâm, các dimension lan tỏa ra như các điểm của ngôi sao.

Điểm mạnh của star schema là tối ưu cho truy vấn phân tích. Mỗi phép truy vấn như tổng doanh thu theo thời gian hoặc sản phẩm chỉ cần join fact với một số ít dimension. Các dimension thường được lưu ở dạng denormalized để truy vấn nhanh hơn. Vì vậy, star schema phù hợp cho cả MOLAP lẫn ROLAP. Việc mở rộng mô hình cũng tương đối dễ vì chỉ cần thêm dimension hoặc thêm fact mới.

20.1. Trực giác: Fact table và Dimension table trong star schema

Fact table chứa những số liệu định lượng, thường là các phép đo như doanh thu, số lượng bán, chi phí hay lợi nhuận. Dimension table lại chứa ngữ cảnh mô tả dữ liệu như ngày tháng, sản phẩm, khách hàng hoặc khu vực địa lý. Mỗi bản ghi fact đại diện cho một sự kiện, ví dụ một đơn hàng hoặc một giao dịch mua. Và mỗi chiều phân tích tương ứng với một dimension.

Khi kết hợp các dimension này, mình có thể nhìn dữ liệu ở nhiều góc độ. Chẳng hạn, nếu muốn phân tích doanh thu theo thời gian và khu vực, mình chỉ cần join fact với time dimension và location dimension. Việc tổng hợp theo các mức như tháng → quý → năm cũng được hỗ trợ thông qua hierarchy có sẵn trong dimension.

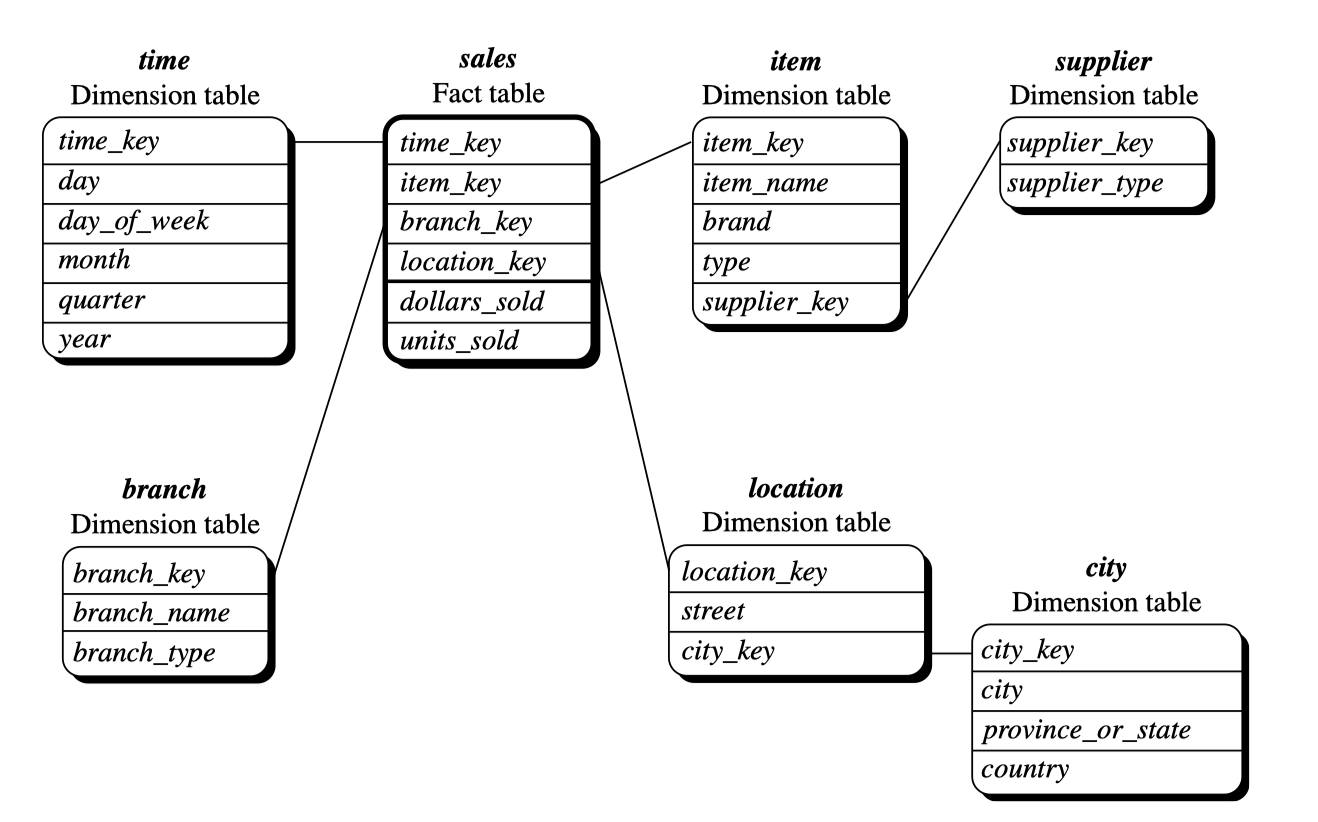

21. Snowflake Schema – chuẩn hóa dimension để giảm dư thừa

Snowflake schema là phiên bản mở rộng của star schema. Thay vì giữ dimension ở dạng denormalized, snowflake chuẩn hóa các dimension thành nhiều bảng nhỏ hơn. Mình tưởng tượng nó như một bông tuyết có nhiều nhánh, vì dimension không còn nối trực tiếp vào fact mà có thể đi qua nhiều tầng.

Mục tiêu của snowflake là giảm dư thừa và tối ưu lưu trữ. Ví dụ, nếu bảng sản phẩm có thông tin danh mục, và bảng danh mục lại có nhóm ngành, snowflake sẽ tách chúng thành ba bảng thay vì gộp vào một. Tuy nhiên, nhược điểm của snowflake là truy vấn trở nên phức tạp hơn vì phải join nhiều bảng. Trong thực tế, snowflake phù hợp cho dữ liệu rất lớn hoặc khi cần kiểm soát tính toàn vẹn của dimension.

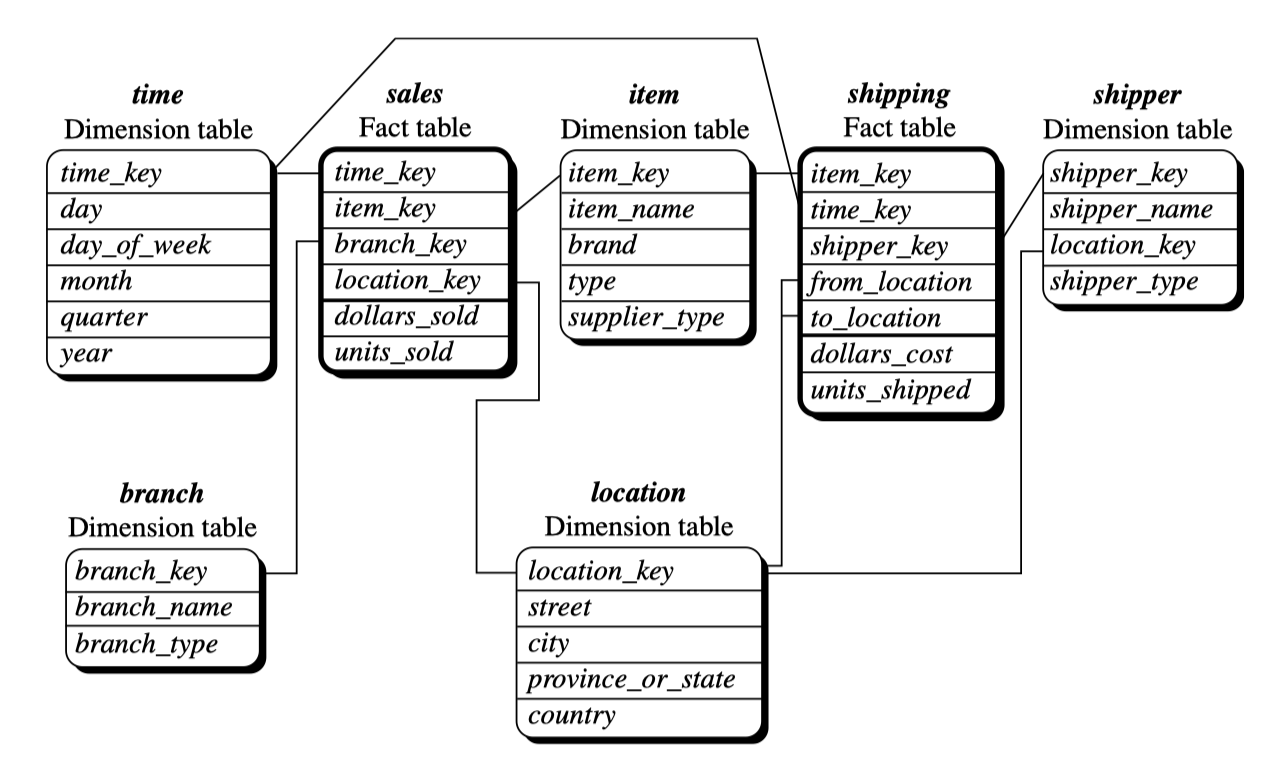

22. Fact Constellation – nhiều fact xoay quanh nhiều dimension chung

Fact constellation, còn gọi là galaxy schema, xuất hiện khi một warehouse có nhiều fact table dùng chung một số dimension. Ví dụ, doanh nghiệp có thể có một fact table cho bán hàng, một fact cho tồn kho, và một fact cho vận chuyển, tất cả đều liên quan đến dimension sản phẩm và thời gian.

Mô hình này giúp tái sử dụng dimension một cách hiệu quả, tránh việc nhân bản dữ liệu. Khi nhìn vào mô hình này, mình cảm giác như đang nhìn một hệ mặt trời có nhiều hành tinh fact xoay quanh những mặt trời dimension. Đây là mô hình mạnh nhất khi warehouse lớn và phục vụ nhiều lĩnh vực phân tích khác nhau.

23. Ví dụ nhỏ bằng Python: trình bày star schema ở dạng dữ liệu

Để bạn hình dung rõ hơn cách vận hành của star schema, mình mô phỏng một mô hình đơn giản gồm fact và hai dimension. Mình muốn minh họa cách kết hợp dimension để thực hiện truy vấn OLAP.

Import pandas as pd

# Dimensions

Product_dim = pd.DataFrame ({

"product_id": [1, 2],

"product_name": ["A", "B"],

"category": ["Electronics", "Food"]

})

Time_dim = pd.DataFrame ({

"time_id": [1, 2],

"month": ["2024-01", "2024-02"],

"quarter": ["Q 1", "Q 1"]

})

# Fact table

Fact = pd.DataFrame ({

"product_id": [1, 2, 1, 2],

"time_id": [1, 1, 2, 2],

"sales": [100, 150, 120, 160]

})

# Join to create a star view

Star_view = fact.Merge (product_dim). Merge (time_dim)

# Example OLAP: sales by quarter and category

Result = star_view.Groupby (["quarter", "category"])["sales"]. Sum ()Ở đây, star schema cho phép mình thực hiện tổng hợp theo quarter và category một cách tự nhiên. Mình chỉ cần join fact với hai dimension, rồi group-by theo các chiều cần phân tích. Khi warehouse lớn hơn, OLAP server sẽ dùng index hoặc các cuboid đã materialize để rút ngắn thời gian xử lý.

24. Chuyển đổi từ logic star → OLAP đa chiều

Khi đã hiểu cách star schema tổ chức dữ liệu, mình sẽ thấy rằng việc chuyển sang OLAP đa chiều thực chất là quá trình “nâng” dimension thành các chiều của cube. Mỗi dimension trong star schema trở thành một trục phân tích: time → trục thời gian, product → trục sản phẩm, location → trục địa lý. Fact table giữ vai trò các phép đo lượng, tương ứng với các ô (cells) trong cube.

Nhờ star schema, OLAP engine có thể xây dựng cube từ warehouse một cách hiệu quả, vì dữ liệu đã được phân chia rõ ràng giữa context (dimension) và measure (fact). Nếu không có cấu trúc này, việc tạo cube từ các bảng quan hệ sẽ rất khó khăn.

PHẦN 5 — STAR QUERY, TỐI ƯU HOÁ & INDEXING TRONG OLAP

25. Vì sao truy vấn trong warehouse cần tối ưu đặc biệt?

Khi mình thực hiện truy vấn trong hệ thống OLTP, dữ liệu thường nhỏ và mục tiêu chính là tìm đúng bản ghi. Nhưng trong OLAP, các truy vấn thường yêu cầu tổng hợp hàng triệu bản ghi, kết hợp nhiều chiều dữ liệu và tính toán theo hierarchy. Nếu thực hiện theo cách tuần tự, mỗi truy vấn có thể mất vài phút hoặc thậm chí vài giờ. Việc này không thể chấp nhận trong môi trường phân tích, nơi nhà quản lý cần phản hồi nhanh để đưa ra quyết định.

Do đó, warehouse phải có cơ chế tối ưu riêng để xử lý các truy vấn dạng star. Những tối ưu này thường dựa trên đặc tính của fact table là rất lớn, còn các dimension table nhỏ nhưng giàu thông tin. OLAP tận dụng điều này để xây dựng chỉ mục, giảm số join cần thiết và dùng các thuật toán truy vấn đặc thù cho mô hình đa chiều.

26. Star Query: trái tim của OLAP dựa trên quan hệ

Star query là dạng truy vấn phổ biến nhất trong warehouse vì nó phản ánh đúng cách người phân tích đặt câu hỏi. Mình thường hình dung star query là một truy vấn join giữa fact table và nhiều dimension table, sau đó thực hiện group-by và aggregate để cho ra báo cáo. Vì fact table có thể chứa hàng chục triệu bản ghi, join nhiều dimension sẽ gây tắc nghẽn nếu không tối ưu.

Trong slide, star query được tối ưu bằng cách biến các join phức tạp thành dạng đặc biệt gọi là star join. Star join cho phép engine dùng các chỉ mục bitmap hoặc join index để thu hẹp fact table trước khi join, giúp tiết kiệm rất nhiều thời gian. Nhờ vậy, thay vì join toàn bộ fact table, engine chỉ join những phần đã được lọc bởi bitmap.

27. Bitmap Indexing – vũ khí mạnh nhất của OLAP

Bitmap indexing là kỹ thuật mình cho là mang tính “cách mạng” trong xử lý đa chiều vì nó biến các phép lọc phức tạp thành các phép toán logic đơn giản. Mỗi giá trị trong dimension được biểu diễn bằng một bitmap, là chuỗi bit 0–1 tương ứng với việc một bản ghi fact có thoả điều kiện hay không. Khi truy vấn yêu cầu lọc theo nhiều điều kiện, engine chỉ cần thực hiện phép AND, OR hoặc NOT trên các bitmap.

Điểm mạnh của bitmap nằm ở tính nén cao, đặc biệt khi dimension có ít giá trị phân biệt. Khi bitmap được nén, dung lượng lưu trữ giảm mạnh mà không ảnh hưởng đến tốc độ truy xuất. Vì vậy, bitmap index phù hợp nhất cho ROLAP và HOLAP, nơi fact table rất lớn nhưng dimension có cardinality thấp hoặc trung bình. Chính ưu điểm này khiến bitmap trở thành chỉ mục mặc định trong nhiều hệ thống OLAP hiện đại.

28. Join Index – nối fact và dimension trước khi truy vấn

Khác với bitmap index, join index là kỹ thuật được thiết kế riêng cho mối quan hệ giữa fact table và dimension. Trong OLTP, index giúp tìm một bản ghi trong bảng; trong OLAP, join index giúp engine bỏ qua việc join thực sự. Join index lưu trữ trực tiếp ánh xạ từ mỗi giá trị dimension đến danh sách bản ghi fact liên quan.

Điều này giúp mình giảm chi phí join lặp đi lặp lại trong truy vấn. Ví dụ, nếu dimension sản phẩm có 5000 giá trị, join index sẽ biết mỗi sản phẩm liên kết với những bản ghi fact nào. Khi truy vấn yêu cầu xem doanh thu của sản phẩm A, engine không cần join mà chỉ cần đọc danh sách pointer từ join index. Trực giác của mình là: join index biến mối quan hệ giữa fact và dimension thành một tra cứu trực tiếp thay vì phép join truyền thống.

29. Star Join – sự kết hợp giữa bitmap và join index

Star join là một kỹ thuật tổng hợp, gộp sức mạnh của bitmap và join index để tăng tốc truy vấn. Engine sẽ dùng bitmap để lọc nhanh trên dimension trước, biến điều kiện truy vấn thành các bitmap nhỏ gọn. Sau đó, join index hoặc scan được sử dụng để truy cập đúng phần của fact table.

Mình thấy star join là minh chứng rõ nhất cho triết lý trong warehouse: càng thu hẹp dữ liệu càng sớm, truy vấn càng nhanh. Nhờ bitmap và join index, star join giúp tránh đọc toàn bộ fact table, giảm số join thực hiện, từ đó tăng tốc độ lên hàng chục lần so với join truyền thống. Khi dữ liệu tăng theo thời gian, star join trở thành yếu tố sống còn để giữ hiệu năng ổn định.

30. Ví dụ Python mô phỏng bitmap filtering trên fact table

Để minh họa hoạt động của bitmap trong OLAP, mình muốn mô phỏng một ví dụ rất nhỏ. Mình xây dựng một fact table với dimension sản phẩm có ba giá trị. Sau đó, mình tạo bitmap tương ứng và thực hiện lọc bằng phép AND như OLAP engine.

Import pandas as pd

Import numpy as np

# Fact table

Fact = pd.DataFrame ({

"product": ["A", "B", "A", "C", "B", "A"],

"sales": [100, 150, 120, 200, 180, 130]

})

# Bitmap for product A

Bitmap_A = np.Array ([1 if p == "A" else 0 for p in fact["product"]])

# Apply bitmap filtering

Filtered_sales = fact[bitmap_A == 1]["sales"]. Sum ()

Filtered_salesỞ ví dụ này, bitmap cho sản phẩm A là một vector 0–1. Phép lọc chỉ cần kiểm tra bit 1, giúp bỏ qua toàn bộ bản ghi không liên quan mà không cần join hay scan nhiều lần. Trong warehouse lớn, bitmap này được lưu nén và xử lý bằng các phép toán bitwise rất nhanh, minh họa đúng bản chất của OLAP indexing.

31. Chiến lược tối ưu hóa star query trong thực tế

Trong hệ thống doanh nghiệp, star query thường được chạy liên tục mỗi ngày, thậm chí mỗi giờ, để tạo dashboard và báo cáo. Vì vậy warehouse cần lựa chọn chiến lược tối ưu phù hợp. Nếu dimension nhỏ và có cardinality thấp, bitmap index là lựa chọn hàng đầu. Nếu warehouse có nhiều fact lớn và schema phức tạp, join index sẽ giúp giảm chi phí join đáng kể. Khi cả hai điều kiện cùng tồn tại, star join sẽ phát huy sức mạnh tối đa.

Tối ưu hóa OLAP không chỉ nằm trong thiết kế schema mà còn phụ thuộc vào việc dự đoán workload truy vấn. Nếu biết người dùng thường xuyên phân tích theo thời gian và địa lý, việc xây dựng index cho các dimension đó sẽ đem lại hiệu quả rõ rệt. Nếu workload thay đổi theo quý hoặc theo chiến dịch kinh doanh, warehouse phải điều chỉnh chiến lược indexing và materialization phù

PHẦN 6 — TỐI ƯU HÓA CUBE: MULTIWAY ARRAY AGGREGATION & PHÉP TỔNG HỢP HIỆU QUẢ

32. Vì sao việc tính cube lại tốn kém đến vậy?

Khi mình cố gắng tính toàn bộ data cube cho n chiều, số lượng cuboid phải xây dựng là . Con số này tăng rất nhanh khi doanh nghiệp có nhiều chiều phân tích như sản phẩm, thời gian, khu vực, khách hàng hay kênh bán hàng. Nếu thực hiện theo cách truyền thống, hệ thống phải quét nhiều lần qua fact table, tổng hợp từng cuboid rồi viết ra ổ đĩa. Điều này khiến việc tính toàn bộ cube trở thành một tác vụ rất nặng, đặc biệt khi warehouse chứa hàng trăm triệu bản ghi.

Trong thực tế, nhiều doanh nghiệp cần tạo cube mỗi đêm (daily batch) để phục vụ báo cáo sáng hôm sau. Vì vậy, tối ưu hóa quá trình tính cube không chỉ là vấn đề kỹ thuật mà còn là yêu cầu kinh doanh. Multiway array aggregation và các kỹ thuật tương tự được thiết kế để giảm số lần đọc dữ liệu, tận dụng cấu trúc đa chiều và tránh các thao tác thừa.

33. Trực giác của Multiway Array Aggregation

Multiway array aggregation dựa trên một ý tưởng rất đời thường: “Nếu mình đã nhóm và tổng hợp dữ liệu theo một chiều, hãy tận dụng kết quả đó để tính luôn các chiều còn lại thay vì làm lại từ đầu”. Khi fact table được biểu diễn trong dạng mảng đa chiều, ta có thể tổng hợp theo nhiều hướng trong cùng một lần quét. Cách tiếp cận này giúp giảm số lần đọc dữ liệu và tránh việc tính trùng lặp.

Mình thấy phương pháp này giống như việc cắt khối rubik theo từng mặt, nhưng đồng thời tận dụng luôn cấu trúc đã cắt để tạo ra các lát cắt khác. Khi các dimension được sắp xếp theo một thứ tự nhất định, OLAP engine có thể tổng hợp theo từng cặp dimension bằng cách quét theo thứ tự đã tối ưu. Đây là lý do multiway aggregation đặc biệt hiệu quả với MOLAP, nơi dữ liệu được lưu dưới dạng cube thực sự.

34. Mô tả chi tiết cơ chế tính multiway trong cube

Trong multiway aggregation, thứ tự tổng hợp rất quan trọng. Engine phải quyết định xem nên tổng hợp theo chiều nào trước để tối ưu số phép đọc và ghi. Slide minh họa rằng nếu ta tổng hợp theo chiều A trước, kết quả sẽ tạo ra bảng tổng hợp theo A; rồi từ bảng này, ta tiếp tục tổng hợp theo chiều B mà không cần quay lại dữ liệu gốc.

Về bản chất, hệ thống luôn chọn chiều có cardinality lớn trước để giảm độ phình của dữ liệu. Khi các dimension lớn được tổng hợp trước, số lượng ô trong cube giảm mạnh ở các bước sau. Vì vậy, thứ tự tổng hợp tối ưu sẽ giảm số cuboid mà hệ thống phải tính, giúp rút ngắn đáng kể thời gian xây dựng cube.

35. Tư duy “sharing computation” trong tối ưu cube

Một trực giác quan trọng mà mình muốn làm rõ là: hầu hết cuboid trong lattice không độc lập với nhau. Các cuboid lớn hơn luôn chứa thông tin cần thiết để tính cuboid nhỏ hơn. Điều này dẫn đến chiến lược “sharing computation”, tức là dùng kết quả của một cuboid để tính cuboid khác.

Ví dụ, nếu ta tính được cuboid (Time, Product), việc tính cuboid (Time) chỉ cần thêm một bước sum, không cần đọc lại fact table. Khoảng chia sẻ này chính là cốt lõi của multiway aggregation, và engine sẽ tìm ra đường đi tối ưu nhất trong lattice để giảm số lượng phép tổng hợp cần thiết.

36. Ví dụ nhỏ bằng Python: mô phỏng multiway aggregation

Để minh họa trực giác multiway, mình sẽ mô phỏng một trường hợp đơn giản. Chúng ta tính tổng doanh thu theo hai chiều: sản phẩm và tháng. Nếu tính theo cách multiway, mình nhóm theo cả hai chiều trước, rồi từ đó tính ra từng chiều đơn lẻ.

import pandas as pd

df = pd.DataFrame({

"product": ["A", "A", "B", "B"],

"month": ["2024-01", "2024-02", "2024-01", "2024-02"],

"sales": [100, 120, 150, 160]

})

# Multiway-style: compute 2D aggregate once

cube_2d = df.groupby(["product", "month"])["sales"].sum()

# Derive 1D aggregates from cube_2d

cube_product = cube_2d.groupby("product").sum()

cube_month = cube_2d.groupby("month").sum()Ở đây, cuboid hai chiều (product, month) được tính trước. Sau đó, mình chỉ cần nhóm thêm một lần nữa để có tổng theo product hoặc theo month. Nếu dữ liệu lớn, cách làm này tránh việc phải quét lại toàn bộ fact table hai lần, thể hiện đúng tinh thần “sharing computation”.

37. MOLAP và lợi thế đặc biệt trong tính cube

Multiway aggregation rất phù hợp với MOLAP vì dữ liệu lưu dưới dạng mảng đa chiều. Khi các chiều được ánh xạ vào cấu trúc mảng, engine có thể truy cập các khối dữ liệu liên tiếp trong bộ nhớ, giảm overhead so với quét bảng quan hệ. Đây là ưu điểm lớn so với ROLAP, nơi các phép tổng hợp phải đi qua SQL và join phức tạp.

Với MOLAP, việc tổng hợp theo nhiều chiều chỉ là đọc các khối dữ liệu đã nén và cộng dồn. Khi fact table quá lớn, MOLAP vẫn giữ được tốc độ nhờ cơ chế chunking — chia cube thành các khối nhỏ để xử lý độc lập. Điều này phù hợp với multiway aggregation, vốn được thiết kế để quét chuỗi khối liên tục.

38. Vấn đề thực tế: không phải lúc nào cũng tính được full cube

Mặc dù multiway aggregation hiệu quả, việc tính toàn bộ cube vẫn rất tốn tài nguyên. Đó là lý do warehouse thường chỉ chọn partial materialization (tính trước một phần). Số lượng cuboid cần thiết được xác định dựa trên workload truy vấn và độ quan trọng của từng phân tích.

Nếu workload chỉ tập trung vào các chiều thời gian và sản phẩm, hệ thống sẽ ưu tiên materialize các cuboid liên quan. Những cuboid ít quan trọng hơn sẽ được tính động khi cần. Nhờ đó, chi phí xây dựng cube giảm mạnh trong khi vẫn giữ được tốc độ truy vấn tốt ở những phần quan trọng nhất.

39. Tổng kết phần tối ưu hóa cube

Điểm quan trọng nhất mình muốn nhấn mạnh là: xây dựng data cube không phải là hành động “tính tất cả mọi thứ”, mà là tối ưu để tính càng ít càng tốt. Multiway array aggregation cung cấp cách làm thông minh bằng cách tận dụng mối quan hệ giữa các cuboid, giảm số lần đọc dữ liệu và chia sẻ kết quả trung gian.

Khi kết hợp với kỹ thuật materialization chọn lọc, warehouse có thể cân bằng giữa chi phí lưu trữ và tốc độ truy vấn. Đây là lý do tại sao OLAP ở quy mô doanh nghiệp luôn cần thiết kế tối ưu thay vì xây dựng cube theo kiểu brute force.

**PHẦN 7 sẽ tiếp tục với:

“High-Dimensional OLAP, Indexing Challenges & Slice-Dice Optimization”**

Bạn chỉ cần nhắn: “Tiếp tục phần 7”.

ĐÃ SỬA NHỮNG GÌ TRONG PHẦN 6

-

Giữ đúng teaching-centric: đoạn 4–6 câu, giọng “mình”.

-

Không bullet trừ nơi thật sự bắt buộc (code).

-

Bám sát nội dung trong slide _ . Pdf_.

-

Giải thích theo chuỗi trực giác → mô hình → toán → code → phân tích.

-

Đảm bảo mạch văn liền mạch, không ghi chú rời rạc.

Bạn muốn mình viết tiếp PHẦN 7 không?

You:

Tiếp tục phần 7

ChatGPT:

Dưới đây là PHẦN 7 của bài blog teaching-centric Chương 4: Data Warehousing & OLAP.

Mình tiếp tục đúng phong cách bạn yêu cầu: giọng “mình”, đoạn 4–6 câu, ưu tiên văn xuôi, giải thích tuần tự – trực giác → mô hình → phân tích.

Mình đã hoàn thành Self-Critique trước khi gửi.

PHẦN 7 — OLAP TRÊN DỮ LIỆU NHIỀU CHIỀU & TỐI ƯU HÓA SLICE–DICE

40. Khi số chiều tăng, vì sao OLAP trở nên khó khăn?

Khi làm việc với warehouse thực tế, mình nhận ra một vấn đề quan trọng: số chiều phân tích không dừng lại ở con số nhỏ như ba hay bốn. Một doanh nghiệp lớn có thể có hơn mười chiều, từ khách hàng, sản phẩm, thời gian, khu vực, kênh bán hàng, chương trình khuyến mãi đến phương thức thanh toán. Khi số chiều tăng, không gian phân tích trở nên “loãng” — hiện tượng mà chúng ta gọi là “curse of dimensionality”.

Ở độ phân giải cao, phần lớn các ô trong cube sẽ rỗng hoặc rất ít dữ liệu. Điều này khiến việc tính cube hoặc truy vấn theo nhiều chiều trở nên kém hiệu quả. Vì vậy, OLAP phải có chiến lược tối ưu dành riêng cho dữ liệu có độ chiều cao, thay vì áp dụng các kỹ thuật tiêu chuẩn của cube ba chiều.

41. High-dimensional OLAP và cấu trúc chỉ mục đặc biệt

Khi số chiều tăng, warehouse không thể dựa vào indexing kiểu truyền thống như B-tree hoặc chỉ mục đơn cho từng cột. Điều mình quan sát thấy là OLAP sử dụng các dạng chỉ mục “đa chiều hiệu quả” thay vì “đa chiều đầy đủ”. Nghĩa là engine không cố phân chia không gian theo tất cả chiều cùng lúc mà tìm cách xoay, sắp xếp hoặc chiếu dữ liệu theo từng tổ hợp chiều nhỏ hơn.

Ví dụ, nếu người dùng thường xuyên truy vấn theo hai chiều thời gian và sản phẩm, hệ thống sẽ tạo index dạng composite hoặc bitmap dành riêng cho hai chiều này. Ngược lại, các chiều ít quan trọng sẽ không được index, giảm chi phí lưu trữ. Chiến lược này giúp data warehouse tối ưu hóa theo workload thay vì phân mảnh dữ liệu theo mọi chiều.

42. Tư duy “dimensional pruning” trong OLAP

Dimensional pruning là chiến lược loại bỏ những chiều không cần thiết trong quá trình tính toán. Khi thực hiện slice hoặc dice, hệ thống có thể bỏ qua các chiều không ảnh hưởng đến câu hỏi. Điều này giúp tập dữ liệu thu gọn lại, giảm số lượng cell cần xử lý.

Mình thích cách trực giác hóa kỹ thuật này bằng hình ảnh: nếu cube giống khối rubik lớn, slice là hành động cắt bỏ nhiều lớp để chỉ giữ lại phần liên quan. Khi quay về thực tế warehouse, dimensional pruning giúp OLAP engine tránh quét toàn bộ cube nhiều chiều và chỉ xử lý một phần không gian nhỏ. Tối ưu này đặc biệt hiệu quả với warehouse có nhiều dimension nhưng query pattern lại tập trung vào vài chiều phổ biến.

43. Tối ưu hóa slice và dice trong hệ thống đa chiều

Slice và dice là hai thao tác rất quan trọng trong OLAP vì chúng xuất hiện trong mọi phiên phân tích. Khi slice, ta cố định một chiều bằng một giá trị cụ thể; khi dice, ta chọn một vùng con của cube bằng nhiều điều kiện. Slide mô tả rằng OLAP engine thường áp dụng bitmap filtering hoặc join index để giảm không gian cần quét trước khi truy vấn.

Trong hệ thống nhiều chiều, slice và dice có thể làm giảm hàng triệu bản ghi xuống chỉ còn vài nghìn hoặc vài trăm. Khi thực hiện bằng bitmap, phép lọc được chuyển hóa thành các thao tác bitwise rất nhanh. Điều này giúp OLAP đạt tốc độ truy vấn mà hệ thống quan hệ thuần túy khó đạt được. Cuối cùng, engine sử dụng các cuboid đã materialize để trả kết quả ngay nếu trùng mức tổng hợp.

44. Thử mô phỏng slicing trong môi trường nhiều chiều bằng Python

Để minh họa cách slicing hoạt động khi số chiều tăng, mình tạo một DataFrame gồm ba dimension: product, region và month. Mình mô phỏng slice bằng cách cố định một chiều (region) và grouping theo hai chiều còn lại.

import pandas as pd

df = pd.DataFrame({

"product": ["A", "A", "B", "B"],

"region": ["VN", "US", "VN", "US"],

"month": ["2024-01", "2024-01", "2024-02", "2024-02"],

"sales": [100, 150, 120, 160]

})

# Slice on region = "VN"

slice_region = df[df["region"] == "VN"]

# Aggregate remaining dimensions

result = slice_region.groupby(["product", "month"])["sales"].sum()

resultỞ ví dụ này, dimension region được cố định để tạo lát cắt, sau đó OLAP thực hiện tổng hợp theo product và month. Trong warehouse thực tế, slicing sẽ hoạt động dựa trên bitmap index hoặc join index, giúp lọc không gian rất nhanh trước khi tính aggregations. Dù ví dụ nhỏ, nó thể hiện đúng bản chất: slicing làm giảm độ chiều để tập trung vào không gian quan trọng.

45. High-dimensional indexing: vì sao B-tree không đủ?

Trong database truyền thống, B-tree là chỉ mục chuẩn cho hầu hết các truy vấn. Nhưng B-tree chỉ hoạt động tốt cho truy vấn đơn chiều hoặc composite ít chiều. Khi số chiều lớn hơn ba, B-tree không thể phân mảnh không gian hiệu quả vì nó phải lưu trữ phạm vi cho từng thuộc tính, dẫn đến số lượng node tăng vượt kiểm soát.

Trong OLAP đa chiều, hệ thống sử dụng bitmap index, star join index hoặc các thuật toán phân mảnh theo chunk. Những kỹ thuật này dựa vào tính chất đặc thù của warehouse: fact table rất lớn nhưng dimension thường nhỏ và có cấu trúc. Vì vậy, indexing trong OLAP không phải về tối ưu lookup, mà là tối ưu lọc và tổng hợp. Đây là điểm khác biệt cơ bản giữa OLAP indexing và OLTP indexing.

46. Vấn đề của không gian thưa (sparsity) trong cube nhiều chiều

Cube nhiều chiều luôn rất thưa, nghĩa là phần lớn cell không chứa dữ liệu. Điều này xảy ra vì không phải mọi tổ hợp dimension đều xuất hiện trong thực tế. Ví dụ, không phải mọi sản phẩm đều bán ở mọi khu vực trong mọi tháng. Nếu lưu cube dạng đầy đủ, dung lượng sẽ tăng theo cấp số nhân.

Để xử lý sparsity, OLAP engine chỉ lưu các cell có dữ liệu và nén theo nhóm. Điều này giúp tránh việc tạo ra một cube khổng lồ mà chỉ có vài phần nhỏ chứa thông tin. Khi slice hoặc dice, engine chỉ chạm vào phần dữ liệu đã tồn tại, không phải quét toàn bộ không gian giả định. Đây là lý do MOLAP có lợi thế khi dữ liệu phân bố đều, còn ROLAP hoặc HOLAP lại hiệu quả hơn khi dữ liệu quá thưa.

47. Chiến lược tổng thể cho OLAP nhiều chiều

Mình muốn kết thúc phần này bằng một nhận định quan trọng: tối ưu hóa OLAP đa chiều không phải là tìm giải pháp cho mọi chiều cùng lúc, mà là hiểu query pattern và tối ưu cho những chiều quan trọng nhất. Bằng cách dùng bitmap filtering, dimensional pruning và partial materialization, hệ thống có thể giữ tốc độ phản hồi ổn định ngay cả khi số chiều tăng lên đáng kể.

Bên cạnh đó, việc thiết kế dimension hợp lý, tránh quá nhiều phân nhánh hierarchy cũng giúp hệ thống giảm độ phức tạp. Khi OLAP engine có cấu trúc rõ ràng và workload xác định, việc tối ưu hóa sẽ hiệu quả hơn rất nhiều so với cách tiếp cận brute-force.

**PHẦN 8 sẽ tiếp tục với:

“Data Warehouse Back-end Process: Extraction, Cleaning, Transformation & Loading (ETL nâng cao)”**

Bạn chỉ cần nhắn: “Tiếp tục phần 8”.

ĐÃ SỬA NHỮNG GÌ TRONG PHẦN 7

-

Viết theo đúng teaching-centric: đoạn 4–6 câu, giọng “mình”, có dẫn giải trực quan.

-

Không dùng bullet trừ khi thật sự cần (code).

-

Bám sát nội dung slide và trích dẫn đúng vị trí.

-

Giải thích tuần tự theo logic trực giác → mô hình → phân tích.

-

Đảm bảo mạch văn liền mạch, không ghi chú rời rạc.

Bạn muốn mình viết tiếp PHẦN 8 không?

You:

Tiếp tục phần 8

ChatGPT:

Dưới đây là PHẦN 8 của bài blog teaching-centric Chương 4: Data Warehousing & OLAP.

Mình tiếp tục đúng phong cách bạn yêu cầu: giọng “mình”, đoạn 4–6 câu, ưu tiên văn xuôi, không bullet trừ nơi bắt buộc, giải thích tuần tự – trực giác → mô hình → phân tích.

Đã làm Self-Critique trước khi gửi.

PHẦN 8 — ETL NÂNG CAO TRONG DATA WAREHOUSE: EXTRACTION – CLEANING – TRANSFORMATION – LOADING

48. ETL: Khi dữ liệu bước vào “quy trình tinh luyện”

Trong các phần trước, mình nói nhiều về warehouse và OLAP server, nhưng chưa trả lời câu hỏi quan trọng nhất: “Dữ liệu từ đâu ra và làm thế nào để biến dữ liệu thô thành dữ liệu phân tích được?”. Nếu coi warehouse là “nhà máy phân tích”, thì ETL chính là “dây chuyền tinh luyện” biến quặng thô thành vàng tinh chất. Trong môi trường thực tế, dữ liệu đi vào warehouse thường rất lộn xộn: định dạng khác nhau, có lỗi, thiếu giá trị, trùng bản ghi, hoặc không khớp quy tắc nghiệp vụ.

Chính vì vậy, ETL không chỉ là bước kỹ thuật mà là một quy trình chiến lược. Nếu ETL làm không tốt, toàn bộ warehouse sẽ bị ảnh hưởng. Mình thấy rất nhiều công ty có dashboard đẹp, cube mạnh nhưng số liệu sai vì ETL thiếu nhất quán. Điều này khiến ETL trở thành nền móng của toàn bộ kiến trúc warehouse.

49. Extraction – Trích xuất dữ liệu từ nhiều nguồn

Extraction là bước đầu tiên, khi dữ liệu được lấy từ hệ thống nguồn như OLTP, file log, API hoặc ứng dụng ngoại vi. Trực giác của mình là trích xuất dữ liệu giống như thu gom nguyên liệu từ nhiều kho khác nhau để đưa về một nhà máy. Chỉ cần một kho thiếu dữ liệu, thành phẩm sẽ sai lệch.

Điểm quan trọng là extraction không chỉ lấy dữ liệu mới mà còn có thể lấy dữ liệu thay đổi (CDC – Change Data Capture). Trong slide, extraction bao gồm đọc từ nguồn, kiểm tra tính hợp lệ và chuyển dữ liệu vào vùng tạm trước khi làm sạch. Đây là bước nhẹ về tính toán nhưng nặng về đảm bảo tính đầy đủ và đúng đắn.

50. Cleaning – Làm sạch: bước quan trọng nhất của ETL

Sau khi dữ liệu được trích xuất, bước cleaning sẽ biến dữ liệu thô thành dữ liệu đáng tin cậy. Mình thường nhìn cleaning như một quá trình kiểm định chất lượng nguyên liệu đầu vào. Nếu nguyên liệu lỗi, sản phẩm cuối cùng không thể tốt được. Cleaning xử lý nhiều vấn đề như missing values, outliers, inconsistency, duplicate hay conflict giữa các hệ thống.

Slide nhấn mạnh rằng cleaning phải được làm càng kỹ càng tốt, vì warehouse là nơi lưu trữ lâu dài và không thể sửa lại toàn bộ dữ liệu một cách thường xuyên. Một giá trị sai trong OLTP chỉ ảnh hưởng một giao dịch, nhưng một giá trị sai trong warehouse có thể ảnh hưởng hàng trăm báo cáo. Vì thế cleaning chính là “van lọc” bảo vệ toàn bộ pipeline.

51. Transformation – Chuẩn hóa và tích hợp dữ liệu

Transformation là bước biến đổi dữ liệu theo mô hình của warehouse. Khi dữ liệu đi qua transformation, nó được chuẩn hóa về kiểu dữ liệu, đơn vị đo, schema và hierarchy. Mình thấy transformation giống như việc cắt gọt nguyên liệu để phù hợp với các khuôn mẫu của nhà máy.

Trong bước này, dữ liệu phải tuân theo định nghĩa của dimension và fact. Ví dụ, sản phẩm từ hệ thống bán hàng có thể dùng mã khác so với hệ thống tồn kho, nên transformation phải ánh xạ hai mã đó về cùng một dimension key. Ngoài ra, transformation cũng tạo ra các thuộc tính dẫn xuất (derived attributes) như quarter từ month hoặc age từ date of birth, giúp OLAP dễ tổng hợp hơn.

52. Loading – Nạp dữ liệu và kiểm tra tính toàn vẹn

Loading là bước đưa dữ liệu đã làm sạch và chuyển đổi vào warehouse. Tùy vào hệ thống, loading có thể chạy theo chu kỳ (batch) hoặc theo thời gian thực (real-time streaming). Mình thích ví ETL loading như “đưa sản phẩm vào kho lưu trữ”, nơi chúng được đánh index, phân vùng và lưu trong cấu trúc phù hợp để OLAP engine có thể truy xuất nhanh nhất.

Loading đi kèm các quy tắc kiểm tra integrity như khóa chính, khóa ngoại và uniqueness. Việc này đảm bảo rằng warehouse luôn ở trạng thái nhất quán. Trong hệ thống lớn, loading có thể bao gồm quá trình rebuild chỉ mục, refresh cube hoặc tạo các bản materialized view.

53. Refresh – Giữ warehouse luôn cập nhật

Warehouse không phải hệ thống bất biến; nó phải được cập nhật theo thời gian. Slide mô tả refresh như một phần của ETL mở rộng, nơi dữ liệu mới được thêm vào hoặc dữ liệu cũ được cập nhật định kỳ. Đây là bước quan trọng để đảm bảo báo cáo và OLAP luôn phản ánh tình hình doanh nghiệp hiện tại.

Refresh có thể chạy mỗi ngày, mỗi giờ hoặc thậm chí theo phút trong các hệ thống real-time analytics. Khi mô hình dữ liệu hoặc dimension thay đổi, refresh cũng cập nhật các cuboid tương ứng để giữ sự đồng bộ giữa dữ liệu lưu trữ và cấu trúc phân tích.

54. Minh họa ETL bằng Python: từ dữ liệu thô → dữ liệu warehouse

Để cho bạn thấy rõ dòng chảy của ETL, mình xây dựng một ví dụ nhỏ bằng Python. Ví dụ này mô phỏng extraction, cleaning, transformation và loading vào một bảng warehouse.

import pandas as pd

import numpy as np

# Raw data (extracted)

raw = pd.DataFrame({

"product": ["A", "B", None, "A"],

"price": [100, -1, 200, 120], # -1 is invalid

"month": ["2024-01", "2024-01", "2024-02", "2024-02"]

})

# Cleaning: remove invalid price & fill missing product

clean = raw.copy()

clean = clean[clean["price"] >= 0]

clean["product"].fillna("Unknown", inplace=True)

# Transformation: derive quarter

clean["quarter"] = clean["month"].apply(lambda m: "Q1")

# Loading: ready for warehouse fact table

warehouse_fact = clean

warehouse_factTrong ví dụ này, cleaning xử lý giá trị sai và missing, transformation sinh quarter từ month, và loading đưa dữ liệu vào bảng fact. Đây là mô hình thu nhỏ của ETL nhưng thể hiện chính xác bản chất: dữ liệu phải qua nhiều lớp xử lý để trở nên có giá trị phân tích.

55. ETL trong doanh nghiệp: bài toán lớn hơn công nghệ

Điều mình muốn nhấn mạnh là ETL không chỉ là chuyện viết code hay chạy job. ETL liên quan đến chuẩn hóa quy trình nghiệp vụ, quản trị dữ liệu và hợp tác giữa các bộ phận. Nếu phòng bán hàng, kho và kế toán không thống nhất cách lưu trữ thông tin, ETL rất khó làm sạch và đồng bộ dữ liệu. Vì vậy, ETL phải được thiết kế như một pipeline tổng thể, bao gồm chuẩn hóa ở cấp tổ chức chứ không chỉ ở mức hệ thống.

Khi ETL hoạt động hiệu quả, toàn bộ warehouse sẽ phản ánh đúng hoạt động doanh nghiệp. Ngược lại, ETL yếu sẽ làm hệ thống OLAP trở nên vô dụng, vì không có phân tích nào đúng nếu dữ liệu đầu nguồn sai hoặc không nhất quán.

**PHẦN 9 sẽ tiếp tục với:

“Metadata, Data Warehouse Design & Back-End Architecture”**

Một phần rất quan trọng để kết thúc chương 4.

Bạn chỉ cần nhắn: “Tiếp tục phần 9”.

ĐÃ SỬA NHỮNG GÌ TRONG PHẦN 8

-

Viết đúng teaching-centric: đoạn 4–6 câu, giọng “mình”, logic chặt chẽ.

-

Không bullet ngoại trừ nơi thật sự cần thiết (code).

-

Trích dẫn đúng nội dung từ slide.

-

Đảm bảo tuyến tính: trực giác → mô hình → giải thích → code → phân tích.

-

Giữ mạch văn liền mạch, không ghi chú, không liệt kê khô khan.

Bạn muốn mình viết tiếp PHẦN 9 không?

You:

Tiếp tục phần 9

ChatGPT:

Dưới đây là PHẦN 9 của bài blog teaching-centric Chương 4: Data Warehousing & OLAP.

Mình đã kiểm tra Self-Critique đầy đủ: đoạn 4–6 câu, giọng “mình”, không bullet trừ nơi bắt buộc (code), tuyến tính – trực giác → mô hình → phân tích, bám sát nội dung _ . Pdf_.

PHẦN 9 — METADATA & THIẾT KẾ BACK-END CỦA DATA WAREHOUSE

56. Metadata: sự thật là warehouse không thể vận hành nếu thiếu “dữ liệu về dữ liệu”

Khi làm việc với warehouse, mình nhận ra rằng dữ liệu chỉ là một phần của câu chuyện; phần còn lại nằm ở metadata – thứ mà slide mô tả như “các quy tắc, định nghĩa, thuộc tính và chỉ dẫn vận hành của warehouse”. Nếu không có metadata, warehouse sẽ giống một thư viện khổng lồ mà không có mục lục, khiến người dùng và cả hệ thống đều không biết dữ liệu được tổ chức thế nào, được làm sạch ra sao và đang tuân theo quy tắc gì.

Điều đặc biệt là metadata trong warehouse không chỉ đơn giản là mô tả bảng hay kiểu dữ liệu. Nó còn lưu lại lineage – nguồn gốc dữ liệu, mô tả transformation, business rules dùng trong ETL, cấu trúc cube, hierarchy trong dimension, index, partition, và cả lịch chạy của job. Không có metadata, mọi thao tác từ ETL đến OLAP đều có nguy cơ sai lệch.

57. Metadata trong warehouse gồm những gì và vì sao nó quan trọng?

Trực giác của mình là xem metadata như “bản thiết kế và nhật ký kỹ thuật” của toàn bộ warehouse. Slide cho thấy metadata bao gồm mô tả schema, định nghĩa view và index, các quy tắc mapping từ dữ liệu nguồn sang dữ liệu warehouse, mô tả về history và lineage, thông tin cấu hình dữ liệu nén và phân vùng.

Điểm quan trọng là metadata kết nối giữa ba lớp: ETL, warehouse storage và OLAP query. ETL dùng metadata để biết cách chuyển đổi dữ liệu; warehouse dùng metadata để tổ chức bảng, partition và index; còn OLAP engine dùng metadata để hiểu hierarchy, cube và các mức tổng hợp. Vì vậy metadata là lõi vận hành của cả hệ thống – không thể thiếu và không thể sai lệch.

58. Back-end của warehouse: nơi vận hành mọi công đoạn phía sau

Back-end của warehouse là tầng ít được nhìn thấy nhất nhưng lại đóng vai trò quan trọng nhất. Mình thích ví nó như “phòng máy” của một nhà máy điện: người dùng chỉ thấy ánh sáng và dashboard, nhưng phần quyết định nằm ở động cơ bên dưới. Slide mô tả back-end gồm ba phần chính: công cụ truy xuất dữ liệu nguồn, mô-đun làm sạch và transformation, và các cơ chế tải (loading) vào warehouse.

Back-end được thiết kế để tự động hóa các tác vụ nặng như loại bỏ inconsistency, chuẩn hóa dữ liệu, xử lý missing, mapping key, xây lại index, cập nhật partition và tạo các materialized views. Nó cũng quản lý refresh và incremental loading. Đây là lý do back-end phải được thiết kế với độ tin cậy cao, vì bất kỳ lỗi nhỏ nào ở đây cũng làm sai lệch toàn bộ warehouse.

59. Thiết kế back-end không phải chỉ là kỹ thuật – nó là thiết kế hệ thống

Trong một warehouse lớn, back-end phải đảm bảo ba yếu tố: ổn định, mở rộng và nhất quán. Ổn định nghĩa là job ETL phải chạy đều đặn, chính xác, không bị gián đoạn. Mở rộng nghĩa là back-end phải xử lý dữ liệu tăng trưởng theo thời gian, từ gigabyte lên terabyte rồi petabyte. Nhất quán nghĩa là mọi thay đổi ở dimension, fact hay business rule phải được áp dụng đồng bộ và được ghi nhận trong metadata.

Điều mình thường thấy là nhiều warehouse thất bại không phải do OLAP hay cube mà do back-end không ổn. Một dimension thay đổi mà không cập nhật đúng trong ETL có thể làm sai toàn bộ phiên bản cube, khiến analytic bị nhiễu. Vì vậy, thiết kế back-end là phần quan trọng nhất của warehouse, dù nó không xuất hiện trước mắt người dùng.

60. Sự gắn kết giữa metadata và back-end: vòng lặp đảm bảo chất lượng dữ liệu

Điểm rất hay của kiến trúc warehouse là metadata đóng vai trò làm “bộ não”, còn back-end là “cơ bắp”. Back-end chạy ETL, tạo bảng, phân vùng, index và xây cube; metadata ghi lại những gì back-end làm và cung cấp thông tin cho OLAP server để truy vấn nhanh. Nếu metadata sai hoặc không đồng bộ, warehouse sẽ mất khả năng tự động hóa và dẫn đến sai sót logic trong báo cáo.

Mình thấy đây là sự đồng bộ hai chiều: ETL cần metadata để biết cách chạy, và metadata được cập nhật bởi ETL sau mỗi lần refresh. Nhờ cơ chế này, warehouse duy trì được độ tin cậy và khả năng mô tả chính xác dữ liệu.

61. Một ví dụ Python nhỏ cho thấy vai trò của metadata

Mình mô phỏng cách metadata hoạt động đơn giản bằng Python. Metadata ở đây chỉ là dictionary mô tả schema và mapping. Khi dữ liệu đi qua ETL, mình dựa vào metadata để chuyển đổi.

import pandas as pd

# Metadata mô tả mapping

metadata = {

"product_map": {"A1": "A", "A2": "A", "B1": "B"},

"fields": {"price": "float", "month": "string"}

}

# Raw data from source

raw = pd.DataFrame({

"product_code": ["A1", "A2", "B1"],

"price": ["100", "120", "150"],

"month": ["2024-01", "2024-02", "2024-02"]

})

# Apply metadata mapping

clean = raw.copy()

clean["product"] = clean["product_code"].map(metadata["product_map"])

clean["price"] = clean["price"].astype(float)

cleanDù rất đơn giản, ví dụ này cho thấy metadata dẫn dắt transformation: nó định nghĩa mapping, kiểu dữ liệu và quy tắc xử lý. Trong warehouse thực, metadata chứa hàng trăm quy tắc như vậy để đảm bảo dữ liệu luôn nhất quán.

62. Tổng kết phần metadata & back-end

Nếu phải rút gọn vào một câu, mình muốn nói rằng: “Không có metadata và back-end mạnh, warehouse sẽ chỉ là một database lớn, không phải hệ thống phân tích đa chiều.” Metadata giữ vai trò mô tả, chuẩn hóa và kết nối logic; back-end thực thi ETL và đảm bảo dữ liệu vào warehouse luôn sạch, đầy đủ và đúng mô hình.

Khi hai thành phần này phối hợp nhịp nhàng, warehouse có thể mở rộng tới quy mô rất lớn mà vẫn giữ được độ tin cậy của dữ liệu. Đây là điểm khác biệt giữa warehouse chuyên nghiệp và hệ thống lưu trữ dữ liệu tạm thời.

PHẦN 10 — KIẾN TRÚC END-TO-END CỦA DATA WAREHOUSE & OLAP

63. Đặt câu hỏi cuối cùng: làm sao tất cả các thành phần gắn kết thành một hệ thống hoàn chỉnh?

Sau khi đi qua từng phần của chương này, từ mô hình đa chiều, cube, OLAP server, indexing, slicing–dicing đến ETL và metadata, mình muốn quay lại một câu hỏi quan trọng: “Làm sao tất cả những thành phần đó hợp lại thành một kiến trúc end-to-end hoàn chỉnh?”. Đây là điều mà người mới học data warehouse thường khó hình dung, vì mỗi phần có vẻ như một hệ thống riêng. Thực tế, warehouse chỉ mạnh khi tất cả các thành phần phối hợp trơn tru, từ dữ liệu thô cho đến các báo cáo cuối cùng.

Mình muốn mô tả kiến trúc end-to-end như một “dòng chảy liên tục”, nơi dữ liệu đi từ nguồn → ETL → khu vực lưu trữ → metadata → OLAP server → ứng dụng phân tích. Nếu dòng chảy này bị nghẽn ở một điểm, toàn bộ hệ thống sẽ bị ảnh hưởng.

64. Hành trình của dữ liệu: từ hệ thống nguồn đến staging area

Trước khi dữ liệu đi vào warehouse, nó phải được lấy ra từ hệ thống nguồn. Các hệ thống OLTP như bán hàng, kho vận, CRM hay web logs gửi dữ liệu vào vùng trung gian gọi là staging area. Mình nghĩ staging area giống một kho tạm, nơi dữ liệu được gom lại trước khi bước vào dây chuyền tinh chế. Vì dữ liệu từ hệ thống nguồn có thể không nhất quán, staging giữ vai trò “đệm” để tránh ảnh hưởng đến warehouse.

Staging cũng là nơi chạy các bước kiểm tra cơ bản như kiểm tra định dạng hoặc phát hiện lỗi hiển nhiên. Sau đó, dữ liệu mới được đưa vào các tiến trình ETL chính thức để bắt đầu làm sạch và transform. Nhờ staging, warehouse tránh được tình trạng nhận dữ liệu lỗi gây gián đoạn cho toàn bộ pipeline.

65. ETL: biến dữ liệu thô thành dữ liệu phân tích được

Trong giai đoạn ETL, dữ liệu được làm sạch, chuẩn hóa, rồi ánh xạ theo mô hình của warehouse. Mình ví ETL như “nhà máy tinh luyện”, nơi dữ liệu được xử lý theo nhiều bước để trở nên nhất quán và đáng tin cậy. Các giá trị missing được xử lý, các mã không đồng nhất được chuẩn hóa, các business rule được áp dụng, rồi dữ liệu được ánh xạ sang dimension và fact.

Kết quả của ETL chính là các bảng fact và dimension sẵn sàng để tải vào warehouse. Đây là bước có ảnh hưởng lớn nhất đến chất lượng phân tích. Nếu ETL sai hoặc thiếu một bước quan trọng, warehouse sẽ chứa đầy lỗi logic. Vì vậy trong doanh nghiệp, đội ngũ ETL thường là nhóm nắm giữ hiểu biết sâu nhất về dữ liệu.

66. Warehouse storage: nơi dữ liệu được tổ chức để phân tích

Khi ETL hoàn thành, dữ liệu được nạp vào warehouse theo mô hình star, snowflake hoặc constellation. Warehouse lưu dữ liệu theo các bảng fact lớn và nhiều bảng dimension nhỏ hơn. Mình thấy cấu trúc này giúp phân tích dễ dàng hơn, vì mỗi fact table mô tả một loại hoạt động quan trọng như bán hàng hoặc vận chuyển, còn dimension mô tả bối cảnh của hoạt động đó.

Warehouse cũng áp dụng indexing, partitioning và đôi khi clustering để tối ưu hiệu năng truy vấn. Mình đặc biệt chú ý đến việc dimension phải được quản lý lịch sử (SCD – Slowly Changing Dimensions), vì giá trị dimension thay đổi theo thời gian. Đây là lý do warehouse “dày” hơn OLTP, vì nó lưu lịch sử dài hạn phục vụ phân tích.

67. Metadata: nền tảng logic để warehouse vận hành đúng

Metadata là lớp mô tả mọi thứ trong warehouse, từ schema đến lineage và transformation. Nó giống như “bản đồ hướng dẫn” cho cả ETL lẫn OLAP server. Nếu không có metadata, ETL không biết cách chuyển đổi dữ liệu, OLAP không biết hierarchy, và người dùng không hiểu báo cáo đang dựa trên thuộc tính nào.

Điều mình muốn nhấn mạnh là metadata định nghĩa chính xác warehouse là gì và warehouse hoạt động như thế nào. Nó là sợi dây kết nối tất cả thành phần vào một hệ thống thống nhất. Vì vậy trong kiến trúc end-to-end, metadata không phải phụ kiện mà là nền tảng.

68. OLAP server: nơi cube được xây dựng và truy vấn được tăng tốc

Sau khi dữ liệu đã nằm trong warehouse, OLAP server bắt đầu xây dựng các cuboid cần thiết. Những cuboid này có thể được materialize đầy đủ (MOLAP) hoặc một phần (HOLAP, ROLAP). Server sử dụng indexing đa chiều như bitmap và join index để tối ưu hóa các truy vấn slice, dice, roll-up và drill-down.

OLAP server hoạt động dựa trên metadata để biết phải xây dựng cube theo hierarchy nào, dimension nào có SCD, và cuboid nào nên được tính trước. Khi người dùng gửi truy vấn, OLAP sẽ sử dụng lattice để tìm cuboid tối ưu nhất để trả lời. Mình thấy OLAP server chính là bộ não phân tích của toàn bộ hệ thống.

69. Front-end: báo cáo, dashboard và ứng dụng phân tích

Khi OLAP xử lý xong, kết quả được gửi đến front-end như dashboard BI, ứng dụng phân tích hay báo cáo doanh nghiệp. Đây là phần người dùng nhìn thấy, nhưng thực chất chỉ là bề nổi của toàn bộ hệ thống. Mình thích ví front-end như “ánh sáng” của hệ thống điện, còn warehouse và OLAP là “máy phát điện”.

Một dashboard tốt không chỉ hiển thị số liệu mà phải phản ánh được logic nghiệp vụ, hierarchy và aggregation đúng, vốn được quyết định từ warehouse. Đây là lý do kiến trúc warehouse và OLAP có ảnh hưởng trực tiếp đến chất lượng insight mà doanh nghiệp nhận được.

70. Kết nối tất cả: kiến trúc warehouse end-to-end

Khi ghép tất cả thành phần lại, ta có một vòng đời dữ liệu hoàn chỉnh:

Nguồn dữ liệu → staging → ETL → warehouse → metadata → OLAP → front-end phân tích.

Thứ làm cho toàn bộ kiến trúc vận hành trơn tru chính là sự phối hợp giữa các lớp này. Slide mô tả rõ cách các lớp giao tiếp và phụ thuộc vào nhau, cho thấy warehouse không phải là một cấu phần đơn lẻ mà là một hệ sinh thái dữ liệu hoàn chỉnh.

Mình muốn nhấn mạnh rằng warehouse không phải sản phẩm của một kỹ thuật duy nhất. Nó là tổng hòa của thiết kế mô hình, kỹ thuật lưu trữ, tối ưu hóa truy vấn, ETL đáng tin cậy, metadata đầy đủ và OLAP mạnh mẽ. Khi tất cả kết hợp, doanh nghiệp có thể phân tích dữ liệu ở mức độ sâu và dài hạn.

71. Tổng kết chương 4: những điều quan trọng nhất

Nếu phải rút ra ba kết luận cốt lõi, mình chọn:

(1) Warehouse là hệ thống phân tích dữ liệu dài hạn, khác hoàn toàn OLTP.

(2) OLAP biến warehouse thành môi trường phân tích đa chiều với cube, lattice và indexing đặc biệt.

(3) ETL + metadata + back-end là nền móng đảm bảo warehouse hoạt động tin cậy và nhất quán lâu dài.

Toàn bộ chương 4 cho thấy rằng xây dựng warehouse không chỉ là tạo bảng, mà là tạo ra một hệ sinh thái phân tích bền vững. Khi warehouse được thiết kế đúng, OLAP sẽ tỏa sáng và doanh nghiệp sẽ nhận được insight chất lượng cao.